Physikalische Größe genannt die physikalische Eigenschaft eines materiellen Objekts, Prozesses, physikalischen Phänomens, quantitativ charakterisiert.

Der Wert einer physikalischen Größe ausgedrückt durch eine oder mehrere Zahlen, die diese physikalische Größe charakterisieren und die Maßeinheit angeben.

Die Größe einer physikalischen Größe sind die Werte der in der Bedeutung der physikalischen Größe auftretenden Zahlen.

Maßeinheiten physikalischer Größen.

Die Maßeinheit einer physikalischen Größe ist ein fester Größenwert, dem ein numerischer Wert gleich eins zugewiesen wird. Es dient zur quantitativen Angabe von mit ihm homogenen physikalischen Größen. Ein Einheitensystem physikalischer Größen ist eine Menge von grundlegenden und abgeleiteten Einheiten, die auf einem bestimmten Größensystem basieren.

Nur wenige Einheitensysteme haben sich verbreitet. In den meisten Fällen verwenden viele Länder das metrische System.

Grundeinheiten.

Physikalische Größe messen - bedeutet, es mit einer anderen ähnlichen physikalischen Größe zu vergleichen, die als Einheit genommen wird.

Die Länge eines Objekts wird mit einer Längeneinheit verglichen, das Körpergewicht - mit einer Gewichtseinheit usw. Aber wenn ein Forscher die Länge in Sazhen und ein anderer in Fuß misst, wird es für ihn schwierig sein, diese beiden Werte zu vergleichen. Daher werden alle physikalischen Größen auf der ganzen Welt normalerweise in denselben Einheiten gemessen. 1963 wurde das Internationale Einheitensystem SI (System International – SI) eingeführt.

Für jede physikalische Größe im Einheitensystem muss eine entsprechende Maßeinheit angegeben werden. Standard Einheiten ist seine physikalische Verwirklichung.

Der Längenstandard ist Meter- der Abstand zwischen zwei Schlägen, die auf einen speziell geformten Stab aus einer Legierung aus Platin und Iridium aufgetragen werden.

Standard Zeit ist die Dauer jedes sich korrekt wiederholenden Vorgangs, der als Bewegung der Erde um die Sonne gewählt wird: Die Erde macht eine Umdrehung pro Jahr. Aber die Zeiteinheit ist kein Jahr, sondern gib mir eine Sekunde.

Für eine Einheit Geschwindigkeit Nehmen Sie die Geschwindigkeit einer solchen gleichmäßigen geradlinigen Bewegung, bei der der Körper in 1 s eine Bewegung von 1 m ausführt.

Für Fläche, Volumen, Länge usw. wird eine separate Maßeinheit verwendet. Jede Einheit wird bei der Auswahl des einen oder anderen Standards festgelegt. Das Einheitensystem ist jedoch viel bequemer, wenn nur wenige Einheiten als Haupteinheiten ausgewählt werden und der Rest durch die Haupteinheiten bestimmt wird. Wenn beispielsweise die Längeneinheit ein Meter ist, dann ist die Flächeneinheit ein Quadratmeter, das Volumen ein Kubikmeter, die Geschwindigkeit ein Meter pro Sekunde und so weiter.

Grundeinheiten Die physikalischen Größen im Internationalen Einheitensystem (SI) sind: Meter (m), Kilogramm (kg), Sekunde (s), Ampere (A), Kelvin (K), Candela (cd) und Mol (mol).

|

Grundlegende SI-Einheiten |

|||

|

Wert |

Einheit |

Bezeichnung |

|

|

Name |

Russisch |

International |

|

|

Die Stärke des elektrischen Stroms |

|||

|

Thermodynamische Temperatur |

|||

|

Die Kraft des Lichts |

|||

|

Menge der Substanz |

|||

Es gibt auch abgeleitete SI-Einheiten, die ihre eigenen Namen haben:

|

Abgeleitete SI-Einheiten mit eigenen Namen |

||||

|

Einheit |

Abgeleiteter Einheitsausdruck |

|||

|

Wert |

Name |

Bezeichnung |

Über andere SI-Einheiten |

Durch Basis- und zusätzliche SI-Einheiten |

|

Druck |

m-1 ChkgChs-2 |

|||

|

Energie, Arbeit, Wärmemenge |

m 2 ChkgChs -2 |

|||

|

Kraft, Energiefluss |

m 2 ChkgChs -3 |

|||

|

Strommenge, elektrische Ladung |

||||

|

Elektrische Spannung, elektrisches Potential |

m 2 ChkgChs –3 CHA –1 |

|||

|

Elektrische Kapazität |

m -2 Chkg -1 Hs 4 CHA 2 |

|||

|

Elektrischer Wiederstand |

m 2 ChkgChs –3 CHA –2 |

|||

|

elektrische Leitfähigkeit |

m -2 Chkg -1 Hs 3 CHA 2 |

|||

|

Fluss der magnetischen Induktion |

m 2 ChkgChs –2 CHA –1 |

|||

|

Magnetische Induktion |

kgh -2 CHA -1 |

|||

|

Induktivität |

m 2 ChkgChs –2 CHA –2 |

|||

|

Lichtfluss |

||||

|

Erleuchtung |

m 2 ChkdChsr |

|||

|

Aktivität der radioaktiven Quelle |

Becquerel |

|||

|

Absorbierte Strahlendosis |

||||

UndMessungen. Um eine genaue, objektive und leicht reproduzierbare Beschreibung einer physikalischen Größe zu erhalten, werden Messungen verwendet. Ohne Messungen kann eine physikalische Größe nicht quantifiziert werden. Definitionen wie „niedriger“ oder „hoher“ Druck, „niedrige“ oder „hohe“ Temperatur geben nur subjektive Meinungen wieder und beinhalten keinen Vergleich mit Referenzwerten. Bei der Messung einer physikalischen Größe wird ihr ein bestimmter Zahlenwert zugeordnet.

Gemessen wird mit Messgeräte. Es gibt eine ziemlich große Anzahl von Messgeräten und Vorrichtungen, von den einfachsten bis zu den komplexesten. Zum Beispiel wird die Länge mit einem Lineal oder Maßband gemessen, die Temperatur mit einem Thermometer, die Breite mit einem Messschieber.

Messgeräte werden klassifiziert: nach der Art der Informationsdarstellung (Anzeige oder Aufzeichnung), nach der Messmethode (direkte Aktion und Vergleich), nach der Darstellungsform der Angaben (analog und digital) usw.

Die Messgeräte zeichnen sich durch folgende Parameter aus:

Messbereich- der Wertebereich des Messwerts, auf den das Gerät während seines normalen Betriebs (bei einer bestimmten Messgenauigkeit) ausgelegt ist.

Empfindlichkeitsschwelle- der Mindestwert (Schwellenwert) des Messwerts, der vom Gerät unterschieden wird.

Empfindlichkeit- bezieht sich auf den Wert des gemessenen Parameters und die entsprechende Änderung der Instrumentenablesungen.

Genauigkeit- die Fähigkeit des Geräts, den wahren Wert des gemessenen Indikators anzuzeigen.

Stabilität- die Fähigkeit des Geräts, eine bestimmte Messgenauigkeit für eine bestimmte Zeit nach der Kalibrierung aufrechtzuerhalten.

In den 50-60er Jahren des 20. Jahrhunderts. manifestierte sich zunehmend der Wunsch vieler Länder, ein einziges universelles Einheitensystem zu schaffen, das international werden könnte. Unter den allgemeinen Anforderungen an Basiseinheiten und abgeleitete Einheiten wurde die Anforderung an die Kohärenz eines solchen Einheitensystems gestellt.

1954 Die X. Generalkonferenz für Maß und Gewicht hat sechs Grundeinheiten für internationale Beziehungen festgelegt: Meter, Kilogramm, Sekunde, Ampere, Grad Kelvin, Kerze.

BEIM 1960 XI. Generalkonferenz für Maß und Gewicht genehmigt Internationales Einheitensystem, abgekürzt SI(die Anfangsbuchstaben des französischen Namens Systeme International d Unites), in russischer Transkription - SI.

Als Ergebnis einiger Änderungen, die von den Generalkonferenzen für Maß und Gewicht 1967, 1971 und 1979 angenommen wurden, umfasst das System jetzt sieben Grundeinheiten (Tabelle 3.3.1).

Tabelle 3.3.1

Grund- und Zusatzeinheiten physikalischer Größen des SI-Systems

| Wert | Einheit | ||||

| Bezeichnung | |||||

| Name | Abmessungen | Empfohlene Bezeichnung | Name | Russisch | International |

| Länge | Hauptsächlich | ||||

| L | Meter | m | m | ||

| Gewicht | M | m | Kilogramm | kg | kg |

| Zeit | T | t | zweite | mit | s |

| Die Stärke des elektrischen Stroms | ich | ich | Ampere | SONDERN | SONDERN |

| Thermodynamische Temperatur | Q | T | Kelvin | Zu | Zu |

| Menge der Substanz | N | n, v | Maulwurf | Maulwurf | mol |

| Die Kraft des Lichts | J | J | candela | CD | CD |

| flache Ecke | Zusätzlich | ||||

| - | - | Bogenmaß | froh | Rad | |

| Fester Winkel | - | - | Steradiant | Heiraten | sr |

Auf dem Territorium unseres Landes gilt das SI-Einheitensystem seit 1. Januar 1982. gemäß GOST 8.417–81. Das SI-System ist eine logische Weiterentwicklung der vorangegangenen Einheitensysteme CGS und MKGSS usw.

Definition und Inhalt der grundlegenden SI-Einheiten.

Gemäß den in verschiedenen Jahren angenommenen Beschlüssen der Generalkonferenz für Maß und Gewicht (CGPM) gelten derzeit die folgenden Definitionen der grundlegenden SI-Einheiten.

Längeneinheit– Meter ist die Länge des Wegs, den Licht im Vakuum in 1/299792458 Bruchteilen einer Sekunde zurücklegt (Entscheidung des XVII CGPM von 1983).

Masseneinheit– Kilogramm- Masse gleich der Masse des internationalen Kilogrammprototyps (Entscheidung des I. CGPM 1889).

Zeiteinheit– zweite ist die Dauer von 9192631770 Strahlungsperioden, die dem Übergang zwischen zwei Hyperfeinniveaus des Grundzustands des Cäsium-133-Atoms entsprechen, das nicht durch externe Felder gestört wird (Entscheidung XIII der CGPM von 1967).

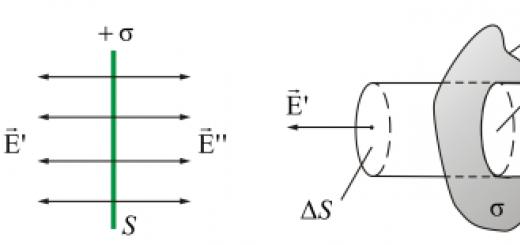

Einheit der elektrischen Stromstärke– Ampere- die Stärke eines konstanten Stroms, der beim Durchgang durch zwei parallele Leiter unendlicher Länge und vernachlässigbaren kreisförmigen Querschnitts, die sich im Vakuum in einem Abstand von 1 m befinden, zwischen diesen Leitern eine Kraft von 2 · 10 erzeugen würde -7 N pro Längenmeter (genehmigt IX CGPM im Jahr 1948).

Einheit der thermodynamischen Temperatur– Kelvin(bis 1967 hieß es Kelvin) - 1/273,16 der thermodynamischen Temperatur des Tripelpunktes von Wasser. Die Angabe der thermodynamischen Temperatur in Grad Celsius ist erlaubt (Resolution XIII der CGPM von 1967).

Mengeneinheit eines Stoffes– Maulwurf- die Stoffmenge eines Systems, das so viele Strukturelemente enthält wie Atome in einem Kohlenstoff-12-Nuklid mit einer Masse von 0,012 kg (Beschluss XIV der CGPM von 1971).

Einheit der Lichtintensität– Candela- Lichtstärke in einer bestimmten Richtung einer Quelle, die monochromatische Strahlung mit einer Frequenz von 540 10 12 Hz ausstrahlt, deren Lichtenergiestärke in dieser Richtung 1/683 W / sr beträgt (Beschluss XVI des CGPM von 1979).

Vortrag 4

Gewährleistung der Einheitlichkeit der Messungen

Einheit der Messungen

Bei der Durchführung von Messungen ist auf deren Einheitlichkeit zu achten. Unter Einheit der Maße verstanden ein Merkmal der Qualität von Messungen, das darin besteht, dass ihre Ergebnisse in gesetzlichen Einheiten ausgedrückt werden, deren Größen innerhalb der festgelegten Grenzen gleich den Größen der reproduzierten Werte sind, und die Fehler der Messergebnisse sind mit einer bestimmten Wahrscheinlichkeit bekannt sind und die festgelegten Grenzen nicht überschreiten.

Das Konzept der "Einheit der Messungen" ist ziemlich umfangreich. Es deckt die wichtigsten Aufgaben der Messtechnik ab: Vereinheitlichung von PV-Einheiten, Entwicklung von Systemen zur Reproduktion von Werten und Übertragung ihrer Größen auf funktionierende Messgeräte mit etablierter Genauigkeit und eine Reihe weiterer Fragen. Die Einheitlichkeit der Messungen ist mit der von Wissenschaft und Technik geforderten Genauigkeit sicherzustellen. Die Aktivitäten der staatlichen und staatlichen Metrologiedienste, die gemäß den festgelegten Regeln, Anforderungen und Normen durchgeführt werden, zielen darauf ab, die Einheitlichkeit der Messungen auf dem richtigen Niveau zu erreichen und aufrechtzuerhalten.

Auf staatlicher Ebene werden Aktivitäten zur Gewährleistung der Einheitlichkeit der Messungen durch die Standards des staatlichen Systems zur Gewährleistung der Einheitlichkeit der Messungen (GSI) oder durch behördliche Dokumente des metrologischen Dienstes geregelt.

Das staatliche System zur Gewährleistung der Einheitlichkeit von Messungen (SSI) ist eine Reihe miteinander verbundener Regeln, Vorschriften, Anforderungen und Normen, die durch Standards festgelegt wurden und die Organisation und Methodik für die Durchführung von Arbeiten zur Bewertung und Gewährleistung der Genauigkeit von Messungen festlegen.

Rechtliche Grundlage Die Gewährleistung der Einheitlichkeit der Messungen ist das gesetzliche Messwesen, bei dem es sich um eine Reihe staatlicher Gesetze (Gesetz der Russischen Föderation „Über die Gewährleistung der Einheitlichkeit der Messungen“), Gesetze und behördliche und technische Dokumente auf verschiedenen Ebenen handelt, die metrologische Regeln, Anforderungen und Normen regeln.

technische Grundlage GSI sind:

1. Das System (der Satz) staatlicher Standards für Einheiten und Skalen physikalischer Größen - die Standardbasis des Landes.

2. Ein System zum Übertragen von Einheitsgrößen und Skalen physikalischer Größen von Standards zu allen SI unter Verwendung von Standards und anderen Überprüfungsmitteln.

3. Ein System zum Entwickeln, Inverkehrbringen und Inverkehrbringen von Arbeitsmessgeräten, die Forschung, Entwicklung und Bestimmung der Eigenschaften von Produkten, technologischen Prozessen und anderen Objekten mit der erforderlichen Genauigkeit ermöglichen.

4. Das System der staatlichen Prüfung von Messgeräten (Bauartzulassung von Messgeräten), die für die Serien- oder Massenproduktion und den chargenweisen Import aus dem Ausland bestimmt sind.

5. System der staatlichen und amtlichen metrologischen Zertifizierung, Überprüfung und Kalibrierung von Messgeräten.

6. System von Standardproben der Zusammensetzung und Eigenschaften von Stoffen und Materialien, System von Standardreferenzdaten über physikalische Konstanten und Eigenschaften von Stoffen und Materialien.

Die Vielfalt der einzelnen Einheiten (Kraft konnte zB in kg, Pfund etc. ausgedrückt werden) und Einheitensystemen bereitete dem weltweiten Austausch wissenschaftlicher und wirtschaftlicher Errungenschaften große Schwierigkeiten. Daher bestand bereits im 19. Jahrhundert die Notwendigkeit, ein einheitliches internationales System zu schaffen, das die Maßeinheiten für Größen umfasst, die in allen Bereichen der Physik verwendet werden. Eine Vereinbarung über die Einführung eines solchen Systems wurde jedoch erst 1960 getroffen.

Internationales Einheitensystem ist eine korrekt konstruierte und miteinander verbundene Menge physikalischer Größen. Es wurde im Oktober 1960 auf der 11. Generalkonferenz für Maß und Gewicht verabschiedet. Der abgekürzte Name des Systems ist -SI. In russischer Transkription - SI. (internationales System).

In der UdSSR wurde 1961 GOST 9867-61 in Kraft gesetzt, das die bevorzugte Verwendung dieses Systems in allen Bereichen der Wissenschaft, Technologie und Lehre festlegt. Derzeit GOST 8.417-81 „GSI. Einheiten physikalischer Größen. Diese Norm legt die in der UdSSR verwendeten Einheiten physikalischer Größen, ihre Namen, Bezeichnungen und Anwendungsregeln fest. Es wurde in voller Übereinstimmung mit dem SI-System und mit ST SEV 1052-78 entwickelt.

Das C-System besteht aus sieben Grundeinheiten, zwei Zusatzeinheiten und einer Reihe von Ableitungen. Zusätzlich zu SI-Einheiten dürfen Submultiple- und Multiple-Einheiten verwendet werden, die durch Multiplikation der Anfangswerte mit 10 n erhalten werden, wobei n = 18, 15, 12, ... -12, -15, -18. Der Name von Vielfach- und Teilmehrfacheinheiten wird durch Hinzufügen der entsprechenden Dezimalpräfixe gebildet:

exa (E) \u003d 10 18; Peta (P) \u003d 10 15; Tera (T) = 10 12 ; Giga (G) = 10 9 ; mega (M) = 10 6 ;

Meilen (m) = 10 -3; Mikro (mk) \u003d 10 -6; Nano (n) = 10 –9; Pico (p) \u003d 10 -12;

femto (f) = 10 -15; atto (a) \u003d 10 -18;

GOST 8.417-81 erlaubt die Verwendung einer Reihe von Einheiten außerhalb des Systems sowie von Einheiten, die vorübergehend bis zur Annahme relevanter internationaler Entscheidungen zugelassen sind, zusätzlich zu den angegebenen Einheiten.

Die erste Gruppe umfasst: Tonne, Tag, Stunde, Minute, Jahr, Liter, Lichtjahr, Voltampere.

Die zweite Gruppe umfasst: Seemeile, Karat, Knoten, Drehzahl.

1.4.4 Grundlegende si-Einheiten.

Längeneinheit - Meter (m)

Das Meter entspricht 1650763,73 Wellenlängen im Strahlungsvakuum, was dem Übergang zwischen den 2p 10 - und 5d 5 -Niveaus des Krypton-86-Atoms entspricht.

Im Internationalen Büro für Maß und Gewicht und in großen nationalen metrologischen Laboratorien wurden Einrichtungen geschaffen, um das Meter in Lichtwellenlängen zu reproduzieren.

Die Einheit der Masse ist das Kilogramm (kg).

Masse ist ein Maß für die Trägheit von Körpern und ihre Gravitationseigenschaften. Das Kilogramm entspricht der Masse des internationalen Kilogrammprototyps.

Das staatliche Primärnormal des SI-Kilogramms dient der Wiedergabe, Speicherung und Übertragung einer Masseeinheit in Gebrauchsnormale.

Die Norm umfasst:

Eine Kopie des internationalen Kilogrammprototyps ist der Platin-Iridium-Prototyp Nr. 12, ein Gewicht in Form eines Zylinders mit einem Durchmesser und einer Höhe von 39 mm.

Gleicharmige Prismenwaage Nr. 1 für 1 kg mit Fernbedienung von Ruphert (1895) und Nr. 2, hergestellt bei VNIIM im Jahr 1966.

Einmal alle 10 Jahre wird der staatliche Standard mit einem Kopierstandard verglichen. Seit 90 Jahren hat sich die Masse des Landesnormals durch Staub, Adsorption und Korrosion um 0,02 mg erhöht.

Nun ist die Masse die einzige Mengeneinheit, die durch ein echtes Normal bestimmt wird. Eine solche Definition hat eine Reihe von Nachteilen - die Änderung der Masse des Standards im Laufe der Zeit, die Nichtreproduzierbarkeit des Standards. Es wird daran gearbeitet, die Einheit der Masse in Form von Naturkonstanten auszudrücken, beispielsweise in Form der Masse des Protons. Es ist auch geplant, einen Standard durch eine bestimmte Anzahl von Si-28-Siliziumatomen zu entwickeln. Um dieses Problem zu lösen, muss zunächst die Genauigkeit der Messung der Avogadro-Zahl verbessert werden.

Die Zeiteinheit ist die Sekunde (s).

Zeit ist einer der zentralen Begriffe unseres Weltbildes, einer der wichtigsten Faktoren im Leben und Handeln der Menschen. Es wird anhand stabiler periodischer Prozesse gemessen - der jährlichen Rotation der Erde um die Sonne, der täglichen Rotation der Erde um ihre Achse, verschiedenen Schwingungsprozessen. Die Definition der Zeiteinheit Sekunden hat sich entsprechend der Entwicklung der Wissenschaft und den Anforderungen an die Messgenauigkeit mehrfach geändert. Nun gibt es folgende Definition:

Eine Sekunde entspricht 9192631770 Strahlungsperioden, die dem Übergang zwischen zwei Hyperfeinniveaus des Grundzustands des Cäsium-133-Atoms entsprechen.

Derzeit wurde ein Strahlstandard für Zeit, Frequenz und Länge erstellt, der vom Zeit- und Frequenzdienst verwendet wird. Funksignale ermöglichen die Übertragung einer Zeiteinheit und sind daher weit verbreitet. Der Fehler des zweiten Standards beträgt 1·10 -19 s.

Die Einheit der Stromstärke ist Ampere (A)

Ein Ampere entspricht der Stärke eines unveränderlichen Stroms, der beim Durchgang durch zwei parallele und geradlinige Leiter unendlicher Länge und vernachlässigbarer Querschnittsfläche, die sich im Vakuum in einem Abstand von 1 Meter voneinander befinden, eine Wechselwirkungskraft verursachen würde gleich 2 10 -7 N.

Der Fehler des Ampere-Standards beträgt 4·10 -6 A. Diese Einheit wird durch die sogenannten Stromskalen wiedergegeben, die als Ampere-Standard genommen werden. Es ist geplant, 1 Volt als Basiseinheit zu verwenden, da der Fehler seiner Reproduktion 5 · 10 -8 V beträgt.

Einheit der thermodynamischen Temperatur - Kelvin (K)

Die Temperatur ist eine Größe, die den Erwärmungsgrad eines Körpers charakterisiert.

Seit der Erfindung des Thermometers durch Galileo basiert die Temperaturmessung auf der Verwendung der einen oder anderen thermometrischen Substanz, die bei einer Temperaturänderung ihr Volumen oder ihren Druck ändert.

Alle bekannten Temperaturskalen (Fahrenheit, Celsius, Kelvin) basieren auf einigen Fixpunkten, denen unterschiedliche Zahlenwerte zugeordnet sind.

Kelvin und unabhängig von ihm Mendelejew äußerten Überlegungen zur Zweckmäßigkeit der Konstruktion einer Temperaturskala auf der Grundlage eines Bezugspunkts, der als "Tripelpunkt des Wassers" angenommen wurde, der der Gleichgewichtspunkt des Wassers im festen, flüssigen und flüssigen Zustand ist gasförmige Phasen. Es kann derzeit in Spezialgefäßen mit einem Fehler von nicht mehr als 0,0001 Grad Celsius reproduziert werden. Als untere Grenze des Temperaturintervalls dient der absolute Nullpunkt. Wenn dieses Intervall in 273,16 Teile geteilt wird, erhalten wir eine Maßeinheit namens Kelvin.

Kelvin ist 1/273,16 der thermodynamischen Temperatur des Tripelpunktes von Wasser.

Um die Temperatur, ausgedrückt in Kelvin, zu bezeichnen, wird das Symbol T verwendet und in Grad Celsius t. Der Übergang erfolgt nach der Formel: T=t+ 273,16. Ein Grad Celsius entspricht einem Kelvin (beide Einheiten sind verwendbar).

Die Einheit der Lichtstärke ist die Candela (cd)

Die Lichtintensität ist eine Größe, die das Leuchten einer Quelle in einer bestimmten Richtung charakterisiert, gleich dem Verhältnis des Lichtstroms zum kleinen Raumwinkel, in dem es sich ausbreitet.

Die Candela ist gleich der Lichtstärke in einer bestimmten Richtung einer Quelle, die monochromatische Strahlung mit einer Frequenz von 540 10 12 Hz aussendet, deren Lichtenergiestärke in dieser Richtung 1/683 (W/sr) (Watt pro Steradiant) beträgt. .

Der Reproduktionsfehler der Einheit nach Norm beträgt 1·10 -3 cd.

Die Mengeneinheit eines Stoffes ist das Mol.

Ein Mol entspricht der Stoffmenge eines Systems, das so viele Strukturelemente enthält, wie Atome in Kohlenstoff C12 mit einer Masse von 0,012 kg vorhanden sind.

Bei der Verwendung des Maulwurfs müssen die Strukturelemente angegeben werden und können Atome, Moleküle, Ionen, Elektronen oder bestimmte Teilchengruppen sein.

Zusätzliche SI-Einheiten

Das internationale System umfasst zwei zusätzliche Einheiten - zum Messen von flachen und festen Winkeln. Sie können nicht einfach sein, da es sich um dimensionslose Größen handelt. Dem Winkel eine unabhängige Dimension zuzuweisen, würde dazu führen, dass die Gleichungen der Mechanik in Bezug auf Rotations- und krummlinige Bewegung geändert werden müssten. Sie sind jedoch keine Ableitungen, da sie nicht von der Wahl der Grundeinheiten abhängen. Daher sind diese Einheiten im SI als zusätzliche Einheiten enthalten, die für die Bildung einiger abgeleiteter Einheiten erforderlich sind - Winkelgeschwindigkeit, Winkelbeschleunigung usw.

Ebene Winkeleinheit - Bogenmaß (rad)

Ein Bogenmaß ist gleich dem Winkel zwischen zwei Radien eines Kreises, dessen Bogenlänge gleich dem Radius ist.

Der staatliche Primärstandard des Bogenmaßes besteht aus einem 36-seitigen Prisma und einer Referenz-Goniometer-Autokollimationseinheit mit einem Teilungswert von Lesegeräten von 0,01 ''. Die Reproduktion der Einheit eines flachen Winkels erfolgt durch das Kalibrierverfahren, basierend auf der Tatsache, dass die Summe aller Mittelpunktswinkel eines polyedrischen Prismas 2π rad beträgt.

Die Einheit des Raumwinkels ist Steradiant (sr)

Der Steradiant ist gleich dem Raumwinkel mit dem Scheitelpunkt in der Mitte der Kugel, der auf der Oberfläche der Kugel eine Fläche ausschneidet, die der Fläche eines Quadrats mit einer Seite entspricht, die dem Radius der Kugel entspricht.

Der Raumwinkel wird gemessen, indem die ebenen Winkel an der Spitze des Kegels bestimmt werden. Der Raumwinkel 1sr entspricht einem flachen Winkel 65 0 32 '. Verwenden Sie zur Neuberechnung die Formel:

wobei Ω der Raumwinkel in sr ist; α ist der flache Winkel am Scheitelpunkt in Grad.

Der Raumwinkel π entspricht dem flachen Winkel 120 0 und der Raumwinkel 2π entspricht dem flachen Winkel 180 0 .

Normalerweise werden Winkel immer noch in Grad gemessen - das ist bequemer.

Vorteile von SI

Es ist universell, dh es deckt alle Messbereiche ab. Mit seiner Implementierung ist es möglich, auf alle anderen Einheitensysteme zu verzichten.

Es ist kohärent, dh ein System, in dem die abgeleiteten Einheiten aller Größen unter Verwendung von Gleichungen mit numerischen Koeffizienten gleich der dimensionslosen Einheit erhalten werden (das System ist verbunden und konsistent).

Die Einheiten im System sind vereinheitlicht (statt einer Reihe von Energie- und Arbeitseinheiten: Kilogramm-Kraft-Meter, Erg, Kalorie, Kilowattstunde, Elektron-Volt usw. - eine Einheit zur Messung von Arbeit und allen Energiearten - das Joule).

Es wird klar zwischen den Einheiten Masse und Kraft (kg und N) unterschieden.

Nachteile von SI

Nicht alle Einheiten haben eine praktische Größe: Die Druckeinheit Pa ist ein sehr kleiner Wert; Einheit der elektrischen Kapazität F ist ein sehr großer Wert.

Die Unbequemlichkeit der Winkelmessung im Bogenmaß (Grad wird leichter wahrgenommen)

Viele abgeleitete Größen haben noch keine eigenen Namen.

Somit ist die Einführung des SI der nächste und sehr wichtige Schritt in der Entwicklung der Metrologie, ein Schritt nach vorn in der Verbesserung von Einheitensystemen für physikalische Größen.

Die General Conference on Weights and Measures (CGPM) definierte 1954 sechs Grundeinheiten physikalischer Größen für ihre Verwendung in internationalen Beziehungen: Meter, Kilogramm, Sekunde, Ampere, Grad Kelvin und Kerze. Die XI. Generalkonferenz für Maß und Gewicht im Jahr 1960 genehmigte das Internationale Einheitensystem, das auf Russisch SI als SI (von den Anfangsbuchstaben des französischen Namens Systeme International d „Einheiten“) bezeichnet wird. In den folgenden Jahren verabschiedete die Generalkonferenz eine Nummer von Hinzufügungen und Änderungen, wodurch das System zu sieben Grundeinheiten, zusätzlichen und abgeleiteten Einheiten physischer Größe wurde (siehe Anhang 19), und auch die folgenden Definitionen von Grundeinheiten entwickelt:

Längeneinheit - Meter ist die Länge des Weges, den Licht im Vakuum in 1/299792458 einer Sekunde zurücklegt;

Masseneinheit - Kilogramm- Masse gleich der Masse des internationalen Kilogrammprototyps;

Zeiteinheit - Sekunde- die Dauer von 9192631770 Strahlungsperioden, die dem Übergang zwischen zwei Hyperfeinniveaus des Grundzustands des Cäsium-133-Atoms ohne Störung durch externe Felder entspricht;

Einheit der elektrischen Stromstärke - Ampere- die Stärke eines unveränderlichen Stroms, der beim Durchgang durch zwei parallele Leiter unendlicher Länge und vernachlässigbaren kreisförmigen Querschnitts, die sich im Vakuum in einem Abstand von 1 m voneinander befinden, zwischen diesen Leitern eine Kraft von 2 · 10 erzeugen würde - 7 Η für jeden Längenmeter;

Einheit der thermodynamischen Temperatur - Kelvin- 1/273,16 Teil der thermodynamischen Temperatur des Tripelpunkts von Jod. Die Verwendung der Celsius-Skala ist ebenfalls erlaubt;

Mengeneinheit eines Stoffes- Maulwurf- die Stoffmenge eines Systems, das so viele Strukturelemente enthält, wie Atome in einem Kohlenstoff-12-Nuklid mit einer Masse von 0,012 kg vorhanden sind;

die Einheit der Lichtstärke ist die Candela- Lichtintensität in einer bestimmten Richtung einer Quelle, die monochromatische Strahlung mit einer Frequenz von 540 · 10 12 Hz aussendet, deren Energiestärke in dieser Richtung 1/683 W/sr beträgt. Die obigen Definitionen sind ziemlich komplex und erfordern ein ausreichendes Niveau

Kenntnisse, insbesondere in Physik. Aber sie geben eine Vorstellung vom natürlichen, natürlichen Ursprung der akzeptierten Einheiten, und ihre Interpretation wurde mit der Entwicklung der Wissenschaft und dank neuer Höchstleistungen in der theoretischen und praktischen Physik, Mechanik, Mathematik und anderen grundlegenden Wissensgebieten komplizierter. Dadurch war es möglich, die Basiseinheiten einerseits zuverlässig und genau darzustellen, andererseits erklärbar und sozusagen für alle Länder der Welt verständlich, was die Hauptvoraussetzung für das System ist von Einheiten, um international zu werden.

Unter physikalische Größe die Eigenschaft physischer Objekte oder Phänomene der materiellen Welt verstehen, die in qualitativer Hinsicht für viele Objekte oder Phänomene allgemein, aber in quantitativer Hinsicht für jedes von ihnen individuell ist. Masse ist zum Beispiel eine physikalische Größe. Qualitativ ist es ein allgemeines Merkmal physischer Objekte, aber quantitativ hat es für verschiedene Objekte eine eigene individuelle Bedeutung.

Unter Bedeutung physikalische Größe ihre Bewertung verstehen, ausgedrückt als Produkt einer abstrakten Zahl mit der für eine gegebene physikalische Größe akzeptierten Einheit. Zum Beispiel im Ausdruck für atmosphärischen Luftdruck R\u003d 95,2 kPa, 95,2 ist eine abstrakte Zahl, die den numerischen Wert des Luftdrucks darstellt, kPa ist die in diesem Fall verwendete Druckeinheit.

Unter Einheit der physikalischen Größe eine physikalische Größe mit fester Größe verstehen und als Grundlage für die Quantifizierung bestimmter physikalischer Größen akzeptiert wird. Als Längeneinheiten werden beispielsweise Meter, Zentimeter usw. verwendet.

Eine der wichtigsten Eigenschaften einer physikalischen Größe ist ihre Dimension. Dimension einer physikalischen Größe spiegelt das Verhältnis einer gegebenen Größe zu den im betrachteten Mengensystem als Hauptgrößen angenommenen Größen wider.

Das Größensystem, das durch das Internationale Einheitensystem SI festgelegt und in Russland übernommen wird, enthält sieben grundlegende Systemgrößen, die in Tabelle 1.1 dargestellt sind.

Es gibt zwei zusätzliche SI-Einheiten – Bogenmaß und Steradiant, deren Eigenschaften in Tabelle 1.2 dargestellt sind.

Aus den Basis- und zusätzlichen SI-Einheiten wurden 18 abgeleitete SI-Einheiten gebildet, denen spezielle, obligatorische Namen zugeordnet wurden. Sechzehn Einheiten sind nach Wissenschaftlern benannt, die anderen beiden sind Lux und Lumen (siehe Tabelle 1.3).

Bei der Bildung anderer abgeleiteter Einheiten können spezielle Einheitennamen verwendet werden. Abgeleitete Einheiten, die keinen speziellen obligatorischen Namen haben, sind: Fläche, Volumen, Geschwindigkeit, Beschleunigung, Dichte, Impuls, Kraftmoment usw.

Neben SI-Einheiten ist es erlaubt, dezimale Vielfache und Teiler davon zu verwenden. Tabelle 1.4 zeigt die Namen und Bezeichnungen der Präfixe solcher Einheiten und ihrer Multiplikatoren. Solche Präfixe werden SI-Präfixe genannt.

Die Wahl der einen oder anderen dezimalen Vielfach- oder Unterzahleinheit wird in erster Linie durch die Bequemlichkeit ihrer Anwendung in der Praxis bestimmt. Grundsätzlich werden solche Vielfachen und Teiler gewählt, bei denen die Zahlenwerte der Größen im Bereich von 0,1 bis 1000 liegen. Statt beispielsweise 4.000.000 Pa sind besser 4 MPa zu verwenden.

Tabelle 1.1. Grundlegende SI-Einheiten

| Wert | Einheit | ||||||

| Name | Abmessungen | Empfohlene Bezeichnung | Name | Bezeichnung | Definition | ||

| International | Russisch | ||||||

| Länge | L | l | Meter | m | m | Ein Meter entspricht der Entfernung, die eine ebene elektromagnetische Welle im Vakuum in 1/299792458 Sekunde zurücklegt | km, cm, mm, µm, nm |

| Gewicht | M | m | Kilogramm | kg | kg | Das Kilogramm entspricht der Masse des internationalen Kilogrammprototyps | Mg, g, mg, mcg |

| Zeit | T | t | zweite | s | mit | Eine Sekunde entspricht 9192631770 Strahlungsperioden während des Übergangs zwischen zwei Hyperfeinniveaus des Grundzustands des Cäsium-133-Atoms | ks, ms, ms, ns |

| Die Stärke des elektrischen Stroms | ich | ich | Ampere | SONDERN | SONDERN | Das Ampere ist gleich der Stärke des sich ändernden Stroms, der sich beim Durchgang durch zwei parallele Leiter unendlicher Länge und einer unbedeutend kleinen Fläche mit kreisförmigem Querschnitt im Vakuum in einem Abstand von 1 m von einem befindet eine andere würde eine Wechselwirkungskraft von 2 · 10 -7 auf jeden Abschnitt des 1 m langen Leiters H verursachen | kA, mA, µA, nA, pA |

| Thermodynamische Temperatur | | T | Kelvin* | Zu | Zu | Kelvin ist gleich 1/273,16 der thermodynamischen Temperatur des Tripelpunktes von Wasser | MK, kK, mK, MK |

| Menge der Substanz | N | n; n | Maulwurf | mol | Maulwurf | Ein Mol entspricht der Stoffmenge eines Systems, das so viele Strukturelemente enthält, wie Kohlenstoff-12-Atome mit einem Gewicht von 0,012 kg vorhanden sind | kmol, mmol, µmol |

| Die Kraft des Lichts | J | J | Candela | CD | CD | Die Candela ist gleich der Lichtintensität in einer bestimmten Richtung einer Quelle, die monochromatische Strahlung mit Frequenzen von 540 10 12 Hz aussendet, deren Strahlungsstärke in dieser Richtung 1/683 W / sr beträgt | |

* Ohne Kelvin-Temperatur (Symbol T) ist es auch möglich, die Celsius-Temperatur (Symbol t) definiert durch den Ausdruck t = T- 273,15 K. Die Kelvin-Temperatur wird in Kelvin und die Celsius-Temperatur in Grad Celsius (°C) ausgedrückt. Das Kelvin-Temperaturintervall oder die Temperaturdifferenz wird nur in Kelvin ausgedrückt. Das Celsius-Temperaturintervall oder die Temperaturdifferenz kann sowohl in Kelvin als auch in Grad Celsius ausgedrückt werden.

Tabelle 1.2

Zusätzliche SI-Einheiten

| Wert | Einheit | Symbole für empfohlene Vielfache und Teiler | ||||||

| Name | Abmessungen | Empfohlene Bezeichnung | Gleichung definieren | Name | Bezeichnung | Definition | ||

| International | Russisch | |||||||

| flache Ecke | 1 | a, b, g, q, n, j | ein = s /r | Bogenmaß | Rad | froh | Ein Bogenmaß ist gleich dem Winkel zwischen zwei Radien eines Kreises, dessen Bogenlänge gleich dem Radius ist | mrad, mkrad |

| Fester Winkel | 1 | w, w | W= S /r 2 | Steradiant | sr | Heiraten | Der Steradiant ist gleich dem Raumwinkel mit dem Scheitelpunkt in der Mitte der Kugel, der auf der Oberfläche der Kugel eine Fläche ausschneidet, die der Fläche eines Quadrats mit einer Seite entspricht, die dem Radius der Kugel entspricht | |

Tabelle 1.3

Abgeleitete SI-Einheiten mit speziellen Namen

| Wert | Einheit | |||

| Name | Abmessungen | Name | Bezeichnung | |

| International | Russisch | |||

| Frequenz | T-1 | Hertz | Hertz | Hertz |

| Stärke, Gewicht | LMT-2 | Newton | N | H |

| Druck, mechanische Spannung, Elastizitätsmodul | L-1 MT-2 | paskal | Pa | Pa |

| Energie, Arbeit, Wärmemenge | L2MT-2 | Joule | J | J |

| Kraft, Energiefluss | L2MT-3 | Watt | W | Di |

| Elektrische Ladung (Strommenge) | TI | Anhänger | Mit | Kl |

| Elektrische Spannung, elektrisches Potential, elektrische Potentialdifferenz, elektromotorische Kraft | L 2 MT-3 I-1 | Volt | v | BEIM |

| Elektrische Kapazität | L -2 M -1 T 4 ICH 2 | Farad | F | F |

| Elektrischer Wiederstand | L 2 MT-3 I-2 | Ohm | | Ohm |

| elektrische Leitfähigkeit | L -2 M -1 T 3 I 2 | Siemens | S | Cm |

| Fluss der magnetischen Induktion, magnetischer Fluss | L 2 MT-2 I-1 | Weber | wb | wb |

| Magnetische Flussdichte, magnetische Induktion | MT-2 I-1 | Tesla | T | Tl |

| Induktivität, Gegeninduktivität | L 2 MT-2 I-2 | Henry | H | gn |

| Lichtfluss | J | Lumen | lm | lm |

| Erleuchtung | L-2J | Luxus | Lux | OK |

| Nuklidaktivität in einer radioaktiven Quelle | T-1 | Becquerel | bq | Bq |

| Absorbierte Strahlendosis, Kerma | L 2 T-2 | grau | Gy | GR |

| Äquivalente Strahlendosis | L 2 T-2 | Sievert | Sv | Sv |

Tabelle 1.4

Namen und Bezeichnungen von SI-Präfixen zur Bildung dezimaler Vielfacher und Teiler und ihrer Multiplikatoren

| Präfixname | Präfixbezeichnung | Faktor | |

| International | Russisch | ||

| Ex | E | E | 10 18 |

| Peta | P | P | 10 15 |

| Tera | T | T | 10 12 |

| giga | G | G | 10 9 |

| mega | M | M | 10 6 |

| Kilo | k | zu | 10 3 |

| Hekto* | h | G | 10 2 |

| Deck* | da | Ja | 10 1 |

| dezi* | d | d | 10 -1 |

| Centi* | c | mit | 10 -2 |

| Milli | m | m | 10 -3 |

| Mikro | | mk | 10 -6 |

| nano | n | n | 10 -9 |

| Bild | p | P | 10 -12 |

| femto | f | f | 10 -15 |

| atto | a | a | 10 -18 |

* Die Präfixe „hecto“, „deca“, „deci“ und „santi“ dürfen nur für weit verbreitete Einheiten verwendet werden, zum Beispiel: Dezimeter, Zentimeter, Dekaliter, Hektoliter.

MATHEMATISCHE OPERATIONEN MIT UNGEFÄHREN ZAHLEN

Als Ergebnis von Messungen sowie bei vielen mathematischen Operationen werden ungefähre Werte der gesuchten Größen erhalten. Daher ist es notwendig, eine Reihe von Berechnungsregeln mit ungefähren Werten zu berücksichtigen. Diese Regeln reduzieren den Rechenaufwand und eliminieren zusätzliche Fehler. Annäherungswerte sind solche Größen wie , Logarithmen usw., verschiedene physikalische Konstanten, Messergebnisse.

Wie Sie wissen, wird jede Zahl mit Zahlen geschrieben: 1, 2, ..., 9, 0; während 1, 2, ..., 9 als signifikante Ziffern gelten.Null kann entweder eine signifikante Ziffer sein, wenn sie sich in der Mitte oder am Ende einer Zahl befindet, oder eine unbedeutende Ziffer, wenn sie sich in einem Dezimalbruch auf der linken Seite befindet und zeigt nur die Ziffer der verbleibenden Ziffern an.

Beim Schreiben einer ungefähren Zahl sollte berücksichtigt werden, dass die Zahlen, aus denen sie besteht, wahr, zweifelhaft und falsch sein können. Anzahl wahr, wenn der absolute Fehler der Zahl kleiner als eine Einheit der Ziffer dieser Ziffer ist (links davon sind alle Ziffern korrekt). Zweifelhaft Rufen Sie die Nummer rechts von der richtigen Nummer und die Nummern rechts von der dubiosen an untreu. Falsche Zahlen müssen nicht nur im Ergebnis, sondern auch in den Originaldaten verworfen werden. Die Zahl muss nicht gerundet werden. Wenn der Fehler einer Zahl nicht angegeben ist, sollte berücksichtigt werden, dass ihr absoluter Fehler gleich der Hälfte der Einerstelle der letzten Ziffer ist. Die Ziffer der höchstwertigen Ziffer des Fehlers zeigt die Ziffer der zweifelhaften Ziffer in der Zahl. Als signifikante Ziffern können nur wahre und zweifelhafte Ziffern verwendet werden, aber wenn der Fehler der Zahl nicht angezeigt wird, sind alle Ziffern signifikant.

Folgende Grundregel für das Schreiben von Näherungszahlen sollte angewendet werden (gemäß ST SEV 543-77): Eine Näherungszahl muss mit einer solchen Anzahl signifikanter Stellen geschrieben werden, die die Richtigkeit der letzten signifikanten Stelle der Zahl garantiert, zum Beispiel :

1) die Zahl 4,6 zu schreiben bedeutet, dass nur ganze Zahlen und Zehntel korrekt sind (der wahre Wert der Zahl kann 4,64; 4,62; 4,56 sein);

2) die Zahl 4,60 zu schreiben bedeutet, dass auch die Hundertstel der Zahl stimmen (der wahre Wert der Zahl kann 4,604; 4,602; 4,596 sein);

3) die Zahl 493 zu schreiben bedeutet, dass alle drei Ziffern richtig sind; kann die letzte Ziffer 3 nicht belegt werden, ist diese Zahl wie folgt zu schreiben: 4,9 10 2;

4) Wenn man die Dichte von Quecksilber 13,6 g / cm 3 in SI-Einheiten (kg / m 3) ausdrückt, sollte man 13,6 10 3 kg / m 3 schreiben und man kann nicht 13600 kg / m 3 schreiben, was die Richtigkeit von fünf bedeuten würde signifikante Ziffern , während in der ursprünglichen Zahl nur drei korrekte signifikante Ziffern angegeben sind.

Die Ergebnisse der Experimente werden nur in signifikanten Zahlen aufgezeichnet. Unmittelbar nach der Nicht-Null-Ziffer wird ein Komma gesetzt, und die Zahl wird mit der entsprechenden Potenz mit zehn multipliziert. Nullen am Anfang oder Ende einer Zahl werden normalerweise nicht aufgeschrieben. Beispielsweise werden die Zahlen 0,00435 und 234000 als 4,35·10 -3 und 2,34·10 5 geschrieben. Eine solche Notation vereinfacht Berechnungen, insbesondere bei Formeln, die zum Logarithmieren geeignet sind.

Das Runden einer Zahl (gemäß ST SEV 543-77) ist die Ablehnung signifikanter Ziffern rechts von einer bestimmten Ziffer mit einer möglichen Änderung der Ziffer dieser Ziffer.

Beim Runden ändert sich die letzte beibehaltene Stelle nicht, wenn:

1) die erste verworfene Ziffer, von links nach rechts gezählt, ist kleiner als 5;

2) Die erste verworfene Ziffer, gleich 5, war das Ergebnis der vorherigen Aufrundung.

Beim Runden wird die zuletzt gespeicherte Stelle um eins erhöht, wenn

1) die erste verworfene Ziffer ist größer als 5;

2) die erste verworfene Ziffer, von links nach rechts gezählt, ist 5 (in Ermangelung vorheriger Rundungen oder in Gegenwart einer vorherigen Abrundung).

Das Runden sollte auf einmal auf die gewünschte Anzahl signifikanter Stellen erfolgen und nicht schrittweise, was zu Fehlern führen kann.

ALLGEMEINE MERKMALE UND KLASSIFIZIERUNG WISSENSCHAFTLICHER EXPERIMENTE

Jedes Experiment ist eine Kombination aus drei Komponenten: dem zu untersuchenden Phänomen (Prozess, Objekt), Bedingungen und Mitteln zur Durchführung des Experiments. Das Experiment wird in mehreren Stufen durchgeführt:

1) Fachliche Untersuchung des untersuchten Prozesses und seiner mathematischen Beschreibung auf der Grundlage der verfügbaren a priori-Informationen, Analyse und Bestimmung der Bedingungen und Mittel zur Durchführung des Experiments;

2) Schaffung von Bedingungen für das Experiment und das Funktionieren des untersuchten Objekts in der gewünschten Weise, um die effektivste Beobachtung davon zu ermöglichen;

3) Sammlung, Registrierung und mathematische Verarbeitung von experimentellen Daten, Präsentation von Verarbeitungsergebnissen in der erforderlichen Form;

5) Verwenden der Ergebnisse des Experiments, z. B. Korrigieren des physikalischen Modells eines Phänomens oder Objekts, Verwenden des Modells zum Vorhersagen, Steuern oder Optimieren usw.

Abhängig von der Art des untersuchten Objekts (Phänomens) werden mehrere Klassen von Experimenten unterschieden: physikalische, technische, medizinische, biologische, wirtschaftliche, soziologische usw. Die am weitesten entwickelten allgemeinen Probleme der Durchführung physikalischer und technischer Experimente, bei denen natürliche oder künstliche untersucht werden physische Objekte (Geräte) und die darin ablaufenden Prozesse. Bei ihrer Durchführung kann der Forscher Messungen physikalischer Größen unter ähnlichen Bedingungen wiederholt wiederholen, die gewünschten Werte der Eingangsvariablen einstellen, sie in großem Umfang ändern, den Einfluss dieser Faktoren beheben oder beseitigen, von denen die Abhängigkeit derzeit nicht besteht Untersucht werden.

Experimente können nach folgenden Kriterien klassifiziert werden:

1) der Grad der Nähe des im Experiment verwendeten Objekts zu dem Objekt, über das neue Informationen gewonnen werden sollen (Feld, Bank oder Polygon, Modell, Computerexperimente);

2) die Ziele des Verhaltens - Forschung, Test (Kontrolle), Verwaltung (Optimierung, Abstimmung);

3) Grad der Beeinflussung der Versuchsbedingungen (passive und aktive Versuche);

4) der Grad der menschlichen Beteiligung (Experimente mit automatischen, automatisierten und nicht automatisierten Mitteln zur Durchführung des Experiments).

Das Ergebnis des Experiments im weitesten Sinne ist ein theoretisches Verständnis der experimentellen Daten und die Aufstellung von Gesetzmäßigkeiten und Ursache-Wirkungs-Beziehungen, die es ermöglichen, den Verlauf von Phänomenen von Interesse für den Forscher vorherzusagen, um solche Bedingungen unter zu wählen denen es möglich ist, den erforderlichen oder günstigsten Verlauf zu erreichen. Im engeren Sinne wird das Ergebnis eines Experiments oft als mathematisches Modell verstanden, das formale funktionale oder probabilistische Zusammenhänge zwischen verschiedenen Variablen, Prozessen oder Phänomenen herstellt.

ALLGEMEINE INFORMATIONEN ÜBER EXPERIMENTELLE WERKZEUGE

Die ersten Informationen für die Erstellung eines mathematischen Modells des untersuchten Phänomens werden mit Hilfe eines Experiments gewonnen, das eine Reihe von Messgeräten verschiedener Art (Messgeräte, Wandler und Zubehör), Informationsübertragungskanäle und Hilfsgeräte umfasst, um sicherzustellen die Bedingungen für die Durchführung des Experiments. Abhängig von den Zielen des Experiments gibt es manchmal Messinformationen (Forschung), Messkontrollen (Kontrolle, Test) und Messkontrollen (Kontrolle, Optimierung) Systeme, die sich sowohl in der Zusammensetzung der Ausrüstung als auch in der Komplexität der experimentellen Verarbeitung unterscheiden Daten. Die Zusammensetzung von Messgeräten wird maßgeblich durch das mathematische Modell des beschriebenen Objekts bestimmt.

Aufgrund der zunehmenden Komplexität experimenteller Untersuchungen umfassen moderne Messsysteme Rechenwerkzeuge verschiedener Klassen (Computer, programmierbare Mikrorechner). Diese Werkzeuge erfüllen sowohl die Aufgaben des Sammelns und der mathematischen Verarbeitung von experimentellen Informationen als auch die Aufgaben der Steuerung des Experimentverlaufs und der Automatisierung der Funktionsweise des Messsystems. Die Wirksamkeit des Einsatzes von Rechenwerkzeugen in Experimenten zeigt sich in folgenden Hauptbereichen:

1) Reduzierung der Zeit für die Vorbereitung und Durchführung des Experiments als Ergebnis der Beschleunigung der Sammlung und Verarbeitung von Informationen;

2) Erhöhung der Genauigkeit und Zuverlässigkeit der Ergebnisse des Experiments basierend auf der Verwendung komplexerer und effizienterer Algorithmen zur Verarbeitung von Messsignalen, wodurch die Menge der verwendeten experimentellen Daten erhöht wird;

3) Verringerung der Zahl der Forscher und Entstehung der Möglichkeit, automatische Systeme zu schaffen;

4) Stärkung der Kontrolle über den Verlauf des Experiments und Erhöhung der Möglichkeiten für seine Optimierung.

Moderne Mittel zur Durchführung eines Experiments sind daher in der Regel Mess- und Rechensysteme (MCS) oder Komplexe, die mit fortschrittlichen Rechenwerkzeugen ausgestattet sind. Bei der Begründung der Struktur und Zusammensetzung des TDF müssen die folgenden Hauptaufgaben gelöst werden:

1) bestimmen Sie die Zusammensetzung der Hardware des IVS (Messinstrumente, Hilfsgeräte);

2) Wählen Sie den Computertyp aus, der Teil des IVS ist;

3) Kommunikationskanäle zwischen dem Computer, den Geräten, die in der Hardware des IVS enthalten sind, und dem Verbraucher von Informationen einrichten;

4) Entwicklung von IVS-Software.

2. PLANUNG DES EXPERIMENTS UND STATISTISCHE VERARBEITUNG DER EXPERIMENTELLEN DATEN

GRUNDLEGENDE KONZEPTE UND DEFINITIONEN

Die meisten Studien werden durchgeführt, um mit Hilfe eines Experiments funktionale oder statistische Zusammenhänge zwischen mehreren Größen herzustellen oder extreme Probleme zu lösen. Die klassische Methode zum Einrichten eines Experiments sieht vor, alle variablen Faktoren auf den akzeptierten Niveaus zu fixieren, mit Ausnahme eines Faktors, dessen Werte sich im Bereich seiner Definition auf bestimmte Weise ändern. Diese Methode bildet die Grundlage für ein Ein-Faktor-Experiment (ein solches Experiment wird oft als passiv). In einem Ein-Faktor-Experiment wird durch Variieren eines Faktors und Stabilisieren aller anderen auf den ausgewählten Niveaus die Abhängigkeit des untersuchten Werts von nur einem Faktor gefunden. Durch die Durchführung einer großen Anzahl von Einzelfaktorexperimenten bei der Untersuchung eines Mehrfaktorsystems werden Frequenzabhängigkeiten erhalten, die durch viele illustrative Graphen dargestellt werden. Auf diese Weise gefundene bestimmte Abhängigkeiten können nicht zu einer großen zusammengefasst werden. Bei einem einfaktoriellen (passiven) Experiment werden statistische Methoden nach dem Ende der Experimente verwendet, wenn die Daten bereits erhoben wurden.

Die Verwendung eines Ein-Faktor-Experiments für eine umfassende Untersuchung eines Mehr-Faktor-Prozesses erfordert eine sehr große Anzahl von Experimenten. Ihre Umsetzung erfordert teilweise erhebliche Zeit, in der sich der Einfluss unkontrollierter Faktoren auf die Ergebnisse von Experimenten erheblich ändern kann. Aus diesem Grund sind die Daten einer Vielzahl von Experimenten unvergleichbar. Daraus folgt, dass die Ergebnisse von Ein-Faktor-Experimenten, die bei der Untersuchung von Mehr-Faktor-Systemen gewonnen werden, für die praktische Anwendung oft wenig brauchbar sind. Außerdem erweisen sich beim Lösen von Extremalproblemen die Daten einer beträchtlichen Anzahl von Experimenten als unnötig, da sie für einen Bereich erhalten wurden, der weit vom Optimum entfernt ist. Für die Untersuchung multifaktorieller Systeme ist die Verwendung statistischer Methoden der Versuchsplanung am besten geeignet.

Unter Versuchsplanung versteht man den Prozess der Bestimmung der Anzahl und der Bedingungen für die Durchführung von Versuchen, die notwendig und ausreichend sind, um das Problem mit der erforderlichen Genauigkeit zu lösen.

Die Versuchsplanung ist ein Zweig der mathematischen Statistik. Es behandelt statistische Methoden zur Gestaltung eines Experiments. Diese Methoden ermöglichen es in vielen Fällen, Modelle multifaktorieller Prozesse mit einer minimalen Anzahl von Experimenten zu erhalten.

Die Wirksamkeit der Verwendung statistischer Methoden der Versuchsplanung bei der Untersuchung technologischer Prozesse erklärt sich aus der Tatsache, dass viele wichtige Eigenschaften dieser Prozesse Zufallsvariablen sind, deren Verteilungen eng dem normalen Gesetz folgen.

Die charakteristischen Merkmale des Versuchsplanungsprozesses sind der Wunsch, die Zahl der Versuche zu minimieren; gleichzeitige Variation aller untersuchten Faktoren nach speziellen Regeln - Algorithmen; die Verwendung eines mathematischen Apparats, der viele der Handlungen des Forschers formalisiert; Wählen Sie eine Strategie, die es Ihnen ermöglicht, nach jeder Versuchsreihe fundierte Entscheidungen zu treffen.

Bei der Planung eines Experiments kommen statistische Methoden in allen Phasen der Studie zum Einsatz und vor allem vor dem Versuchsaufbau, der Entwicklung des Versuchsdesigns sowie während des Versuchs, bei der Aufbereitung der Ergebnisse und nach dem Versuch bei der Entscheidungsfindung Weitere Maßnahmen. Ein solches Experiment heißt aktiv und er nimmt an Versuchsplanung .

Die Hauptvorteile des aktiven Experiments hängen damit zusammen, dass es Folgendes ermöglicht:

1) Minimierung der Gesamtzahl der Experimente;

2) klare, logisch begründete Verfahren wählen, die vom Experimentator während der Studie konsequent durchgeführt werden;

3) Verwenden Sie einen mathematischen Apparat, der viele der Aktionen des Experimentators formalisiert;

4) gleichzeitig alle Variablen variieren und den Faktorraum optimal nutzen;

5) Organisieren Sie das Experiment so, dass viele der anfänglichen Annahmen der Regressionsanalyse erfüllt sind;

6) mathematische Modelle zu erhalten, die im Vergleich zu Modellen, die aus einem passiven Experiment erstellt wurden, in gewissem Sinne bessere Eigenschaften haben;

7) die experimentellen Bedingungen randomisieren, d. h. zahlreiche Störfaktoren in Zufallsvariablen umwandeln;

8) Bewertung des mit dem Experiment verbundenen Unsicherheitsfaktors, der es ermöglicht, die von verschiedenen Forschern erzielten Ergebnisse zu vergleichen.

Meistens wird ein aktives Experiment eingerichtet, um eines von zwei Hauptproblemen zu lösen. Die erste Aufgabe wird aufgerufen extrem. Es besteht darin, die Prozessbedingungen zu finden, die den optimalen Wert des ausgewählten Parameters liefern. Ein Zeichen für Extremalprobleme ist die Anforderung, das Extremum einer Funktion zu finden (*mit einer Grafik veranschaulichen*). Experimente, die zur Lösung von Optimierungsproblemen eingerichtet sind, werden aufgerufen extrem .

Die zweite Aufgabe wird aufgerufen Interpolation. Es besteht darin, eine Interpolationsformel zur Vorhersage der Werte des untersuchten Parameters zu erstellen, die von einer Reihe von Faktoren abhängt.

Um ein Extremal- oder Interpolationsproblem zu lösen, ist ein mathematisches Modell des zu untersuchenden Objekts erforderlich. Das Objektmodell wird unter Verwendung der Ergebnisse von Experimenten erhalten.

Bei der Untersuchung eines multifaktoriellen Prozesses ist das Aufstellen aller möglichen Experimente zum Erhalt eines mathematischen Modells mit einem enormen Aufwand des Experiments verbunden, da die Anzahl aller möglichen Experimente sehr groß ist. Die Aufgabe der Versuchsplanung besteht darin, die mindestens erforderliche Anzahl von Versuchen und die Bedingungen für ihre Durchführung festzulegen, Methoden zur mathematischen Verarbeitung der Ergebnisse auszuwählen und Entscheidungen zu treffen.

HAUPTSTUFEN UND MODI DER STATISTISCHEN VERARBEITUNG VON EXPERIMENTELLEN DATEN

2. Erstellen eines Versuchsplans, insbesondere Bestimmung der Werte unabhängiger Variablen, Auswahl von Testsignalen, Abschätzung des Umfangs der Beobachtungen. Vorläufige Begründung und Auswahl von Methoden und Algorithmen zur statistischen Verarbeitung experimenteller Daten.

3. Direkte experimentelle Forschung, Sammlung experimenteller Daten, deren Registrierung und Eingabe in einen Computer.

4. Vorläufige statistische Aufbereitung von Daten, die zunächst dazu dienen soll, die Erfüllung der dem gewählten statistischen Verfahren zugrunde liegenden Voraussetzungen zur Erstellung eines stochastischen Modells des Untersuchungsobjekts zu überprüfen und ggf. das a priori Modell zu korrigieren und zu verändern Entscheidung über die Wahl des Verarbeitungsalgorithmus.

5. Erstellen eines detaillierten Plans für die weitere statistische Analyse der experimentellen Daten.

6. Statistische Verarbeitung experimenteller Daten (sekundäre, vollständige, endgültige Verarbeitung) mit dem Ziel, ein Modell des Untersuchungsgegenstands zu erstellen, und statistische Analyse seiner Qualität. Manchmal werden gleichzeitig auch die Aufgaben der Verwendung des konstruierten Modells gelöst, zum Beispiel: Die Parameter des Objekts werden optimiert.

7. Formal-logische und aussagekräftige Interpretation der Ergebnisse von Experimenten, Entscheidung über die Fortsetzung oder Beendigung des Experiments, Zusammenfassung der Ergebnisse der Studie.

Die statistische Verarbeitung experimenteller Daten kann in zwei Hauptmodi durchgeführt werden.

Im ersten Modus wird zunächst die gesamte Menge an experimentellen Daten gesammelt und aufgezeichnet und erst dann verarbeitet. Diese Art der Verarbeitung wird Offline-Verarbeitung, A-posteriori-Verarbeitung, Datenverarbeitung an einer Probe des vollen (festen) Volumens genannt. Der Vorteil dieses Verarbeitungsmodus ist die Möglichkeit, das gesamte Arsenal statistischer Methoden zur Datenanalyse und dementsprechend die vollständigste Extraktion experimenteller Informationen daraus zu verwenden. Die Effizienz einer solchen Verarbeitung kann den Verbraucher jedoch möglicherweise nicht zufriedenstellen, außerdem ist die Kontrolle des Experiments fast unmöglich.

Im zweiten Modus werden Beobachtungen parallel zu ihrer Erfassung verarbeitet. Diese Art der Verarbeitung wird Online-Verarbeitung genannt, Verarbeitung von Daten auf einer Stichprobe mit zunehmendem Volumen, sequentielle Datenverarbeitung. In diesem Modus wird es möglich, die Ergebnisse des Experiments schnell zu analysieren und seinen Fortschritt schnell zu kontrollieren.

ALLGEMEINE INFORMATIONEN ÜBER GRUNDLEGENDE STATISTISCHE METHODEN

Bei der Lösung von Problemen der Verarbeitung experimenteller Daten werden Methoden verwendet, die auf zwei Hauptkomponenten des Apparats der mathematischen Statistik basieren: der Theorie der statistischen Schätzung unbekannter Parameter, die zur Beschreibung des Modells des Experiments verwendet werden, und der Theorie des Testens statistischer Hypothesen über die Parameter oder Art des analysierten Modells.

1. Korrelationsanalyse. Sein Wesen besteht darin, den Grad der Wahrscheinlichkeit einer (in der Regel linearen) Verbindung zwischen zwei oder mehreren Zufallsvariablen zu bestimmen. Diese Zufallsvariablen können eingegebene, unabhängige Variablen sein. Dieser Satz kann auch die resultierende (abhängige Variable) enthalten. Im letzteren Fall ermöglicht die Korrelationsanalyse die Auswahl von Faktoren oder Regressoren (im Regressionsmodell), die den größten Einfluss auf das resultierende Merkmal haben. Die ausgewählten Werte werden für weitere Analysen verwendet, insbesondere bei der Durchführung von Regressionsanalysen. Die Korrelationsanalyse ermöglicht es Ihnen, unbekannte kausale Beziehungen zwischen Variablen im Voraus zu entdecken. Dabei ist zu beachten, dass das Vorhandensein einer Korrelation zwischen Variablen nur eine notwendige, aber keine hinreichende Bedingung für das Bestehen kausaler Zusammenhänge ist.

Die Korrelationsanalyse wird in der Phase der vorläufigen Verarbeitung experimenteller Daten verwendet.

2. Dispersionsanalyse. Dieses Verfahren dient der Verarbeitung experimenteller Daten, die von qualitativen Faktoren abhängen, und der Bewertung der Signifikanz des Einflusses dieser Faktoren auf die Ergebnisse der Beobachtungen.

Sein Wesen liegt in der Zerlegung der Varianz der resultierenden Variablen in unabhängige Komponenten, von denen jede den Einfluss eines bestimmten Faktors auf diese Variable charakterisiert. Der Vergleich dieser Komponenten ermöglicht es, die Bedeutung des Einflusses von Faktoren zu beurteilen.

3. Regressionsanalyse. Methoden der Regressionsanalyse ermöglichen es, die Struktur und die Parameter eines Modells zu ermitteln, das die quantitativen Ergebnis- und Faktorvariablen verknüpft, und den Grad seiner Übereinstimmung mit experimentellen Daten zu beurteilen. Diese Art der statistischen Analyse ermöglicht die Lösung des Hauptproblems des Experiments, wenn die beobachteten und resultierenden Variablen quantitativ sind, und in diesem Sinne ist es das Hauptproblem bei der Verarbeitung dieser Art von experimentellen Daten.

4. Faktorenanalyse. Ihr Wesen liegt darin, dass die im Modell verwendeten und stark miteinander verflochtenen „externen“ Faktoren durch andere, kleinere „interne“ Faktoren ersetzt werden sollen, die schwer oder gar nicht messbar sind, aber das Verhalten „externer“ Faktoren bestimmen und damit die resultierende Variable des Verhaltens Faktorenanalyse ermöglicht es, Hypothesen über die Struktur der Beziehung von Variablen aufzustellen, ohne diese Struktur im Voraus zu spezifizieren und ohne Vorinformationen darüber zu haben Diese Struktur wird durch die Ergebnisse von Beobachtungen bestimmt Die resultierenden Hypothesen kann in weiteren Experimenten getestet werden Die Aufgabe der Faktorenanalyse besteht darin, eine einfache Struktur zu finden, die real existierende Abhängigkeiten genau widerspiegelt und reproduziert.

4. HAUPTAUFGABEN DER VORBEREITUNG DER EXPERIMENTELLEN DATEN

Das Endziel der vorläufigen Verarbeitung experimenteller Daten besteht darin, Hypothesen über die Klasse und Struktur des mathematischen Modells des untersuchten Phänomens aufzustellen, die Zusammensetzung und den Umfang zusätzlicher Messungen zu bestimmen und mögliche Methoden für die nachfolgende statistische Verarbeitung auszuwählen. Dazu müssen einige besondere Probleme gelöst werden, unter denen folgende unterschieden werden können:

1. Analyse, Zurückweisung und Wiederherstellung anomaler (fehlerhafter) oder verpasster Messungen, da experimentelle Informationen normalerweise von uneinheitlicher Qualität sind.

2. Experimentelle Überprüfung der Verteilungsgesetze der erhaltenen Daten, Schätzung der Parameter und numerischen Eigenschaften der beobachteten Zufallsvariablen oder Prozesse. Die Wahl der Nachbearbeitungsmethoden, die darauf abzielen, die Angemessenheit eines mathematischen Modells für das untersuchte Phänomen zu konstruieren und zu testen, hängt wesentlich vom Verteilungsgesetz der beobachteten Größen ab.

3. Komprimierung und Gruppierung von Anfangsinformationen mit einer großen Menge experimenteller Daten. Gleichzeitig sollten die Merkmale ihrer Verteilungsgesetze, die in der vorherigen Verarbeitungsphase identifiziert wurden, berücksichtigt werden.

4. Kombinieren mehrerer Gruppen von Messwerten, die möglicherweise zu unterschiedlichen Zeiten oder unter unterschiedlichen Bedingungen erhalten wurden, zur gemeinsamen Verarbeitung.

5. Identifizierung statistischer Zusammenhänge und gegenseitiger Beeinflussung verschiedener Messgrößen und resultierender Größen, aufeinanderfolgende Messungen gleicher Werte. Die Lösung dieses Problems ermöglicht es Ihnen, diejenigen Variablen auszuwählen, die den stärksten Einfluss auf das resultierende Feature haben. Die ausgewählten Faktoren werden zur weiteren Verarbeitung insbesondere durch Regressionsanalyseverfahren verwendet. Die Korrelationsanalyse ermöglicht es, Hypothesen über die Struktur der Variablenbeziehung und letztlich über die Struktur des Phänomenmodells aufzustellen.

Die Vorverarbeitung ist durch eine iterative Lösung der Hauptaufgaben gekennzeichnet, wenn sie nach Erhalt der Ergebnisse in der nachfolgenden Verarbeitungsstufe immer wieder zur Lösung eines bestimmten Problems zurückkehren.

1. KLASSIFIZIERUNG VON MESSFEHLERN.

Unter Messung verstehen, den Wert einer physikalischen Größe experimentell mit speziellen technischen Mitteln zu ermitteln. Messungen können sein Direkte wenn der gewünschte Wert direkt aus den experimentellen Daten gefunden wird, und indirekt wenn der gewünschte Wert auf der Grundlage einer bekannten Beziehung zwischen diesem Wert und den direkt gemessenen Größen bestimmt wird. Der Wert der durch die Messung gefundenen Größe wird aufgerufen Messergebnis .

Die Unvollkommenheit von Messinstrumenten und menschlichen Sinnen und oft die Art der gemessenen Größe selbst führt dazu, dass bei allen Messungen die Ergebnisse mit einer gewissen Genauigkeit erhalten werden, d. H. Das Experiment gibt nicht den wahren Wert des Gemessenen an Menge, sondern nur ihren ungefähren Wert. Unter tatsächlicher Wert einer physikalischen Größe ist ihr experimentell gefundener Wert, der dem wahren Wert so nahe kommt, dass er für diesen Zweck an seiner Stelle verwendet werden kann.

Die Messgenauigkeit wird durch die Nähe ihres Ergebnisses zum wahren Wert der Messgröße bestimmt. Die Genauigkeit des Instruments wird durch den Grad der Annäherung seiner Messwerte an den wahren Wert des gewünschten Werts bestimmt, und die Genauigkeit des Verfahrens wird durch das physikalische Phänomen bestimmt, auf dem es basiert.

Fehler (Fehler) Messungen gekennzeichnet durch die Abweichung der Messergebnisse vom wahren Wert der Messgröße. Der Messfehler ist, ebenso wie der wahre Wert der Messgröße, meist unbekannt. Daher ist eine der Hauptaufgaben der statistischen Verarbeitung der Ergebnisse des Experiments die Bewertung des wahren Werts des gemessenen Werts gemäß den erhaltenen experimentellen Daten. Mit anderen Worten, nachdem der gesuchte Wert wiederholt gemessen und eine Reihe von Ergebnissen erhalten wurden, von denen jedes einen unbekannten Fehler enthält, besteht die Aufgabe darin, den ungefähren Wert des gesuchten Werts mit dem kleinstmöglichen Fehler zu berechnen.

Messfehler werden geteilt durch Rau Fehler (Verfehlungen), systematisch und zufällig .

Grobe Fehler. Grobe Fehler entstehen durch Verletzung der Rahmenbedingungen der Messung oder durch ein Versehen des Experimentators. Wird ein grober Fehler festgestellt, sollte das Messergebnis sofort verworfen und die Messung wiederholt werden. Ein äußeres Zeichen für ein grob fehlerhaftes Ergebnis ist sein starker Größenunterschied zu den übrigen Ergebnissen. Dies ist die Grundlage für einige Kriterien zur Eliminierung von groben Fehlern in Bezug auf ihre Größe (wird weiter unten diskutiert), jedoch ist die zuverlässigste und effektivste Art, falsche Ergebnisse zurückzuweisen, sie direkt im Messprozess selbst zurückzuweisen.

Systematische Fehler. Ein systematischer Fehler ist ein solcher Fehler, der konstant bleibt oder sich bei wiederholten Messungen derselben Größe regelmäßig ändert. Systematische Fehler entstehen durch falsche Einstellung der Instrumente, Ungenauigkeit der Messmethode, jegliche Unterlassung des Experimentators, Verwendung ungenauer Daten für die Berechnung.

Auch bei komplexen Messungen treten systematische Fehler auf. Der Experimentator ist sich ihrer möglicherweise nicht bewusst, obwohl sie sehr groß sein können. Daher ist in solchen Fällen eine sorgfältige Analyse der Messtechnik erforderlich. Solche Fehler können insbesondere durch Messen des Sollwerts mit einem anderen Verfahren erkannt werden. Die Übereinstimmung der Messergebnisse beider Methoden dient als gewisse Garantie für das Fehlen systematischer Fehler.

Bei der Messung müssen alle Anstrengungen unternommen werden, um systematische Fehler zu eliminieren, da diese so groß sein können, dass sie die Ergebnisse stark verfälschen. Die festgestellten Fehler werden durch die Einführung von Änderungen behoben.

Zufällige Fehler. Ein Zufallsfehler ist ein sich zufällig ändernder Bestandteil des Messfehlers, also ein Messfehler, der nach Eliminierung aller identifizierten systematischen und groben Fehler verbleibt. Zufällige Fehler werden durch eine Vielzahl sowohl objektiver als auch subjektiver Faktoren verursacht, die nicht herausgegriffen und getrennt berücksichtigt werden können. Da die zu zufälligen Fehlern führenden Ursachen nicht die gleichen sind und nicht bei jedem Experiment berücksichtigt werden können, sind solche Fehler nicht auszuschließen, man kann ihre Bedeutung nur abschätzen. Mit den Methoden der Wahrscheinlichkeitstheorie kann man deren Einfluss auf die Einschätzung des wahren Wertes der Messgröße mit einem viel kleineren Fehler berücksichtigen als die Fehler einzelner Messungen.

Wenn daher der zufällige Fehler größer als der Fehler des Messgeräts ist, ist es notwendig, dieselbe Messung viele Male zu wiederholen, um ihren Wert zu verringern. Dadurch kann der zufällige Fehler minimiert und mit dem Fehler des Instruments vergleichbar gemacht werden. Wenn der zufällige Fehler kleiner ist als der Fehler des Geräts, dann macht es keinen Sinn, ihn zu reduzieren.

Außerdem werden Fehler eingeteilt in absolut , relativ und instrumental. Ein absoluter Fehler ist ein Fehler, der in Einheiten eines gemessenen Werts ausgedrückt wird. Der relative Fehler ist das Verhältnis des absoluten Fehlers zum wahren Wert der gemessenen Größe. Der Anteil des Messfehlers, der vom Fehler der verwendeten Messgeräte abhängt, wird als instrumenteller Messfehler bezeichnet.

2. FEHLER BEI DIREKTEN GLEICHMESSUNGEN. GESETZ DER NORMALEN VERTEILUNG.

Direkte Messungen- Dies sind solche Messungen, bei denen der Wert der untersuchten Größe direkt aus experimentellen Daten ermittelt wird, beispielsweise durch Ablesen der Messwerte eines Instruments, das den Wert der gewünschten Größe misst. Um den zufälligen Fehler zu finden, muss die Messung mehrmals durchgeführt werden. Die Ergebnisse solcher Messungen haben enge Fehlerwerte und werden aufgerufen gleichwertig .

Lassen Sie als Ergebnis n Mengenmessungen X, durchgeführt mit der gleichen Genauigkeit, wurden eine Reihe von Werten erhalten: X 1 , X 2 , …, X n. Wie in der Fehlertheorie gezeigt, dem wahren Wert am nächsten X 0 Messwert X ist ein arithmetisches Mittel

Das arithmetische Mittel gilt nur als wahrscheinlichster Wert der Messgröße. Die Ergebnisse einzelner Messungen weichen in der Regel vom wahren Wert ab X 0 . Allerdings ist der absolute Fehler ich te Dimension ist

D x ich " = X 0 – x ich 4

und kann mit gleicher Wahrscheinlichkeit sowohl positive als auch negative Werte annehmen. Wenn wir alle Fehler zusammenfassen, erhalten wir

![]() ,

,

![]() . (2.2)

. (2.2)

In diesem Ausdruck steht der zweite Term auf der rechten Seite für groß n gleich Null ist, da jedem positiven Fehler ein gleicher negativer Fehler zugeordnet werden kann. Dann X 0 =. Bei einer begrenzten Anzahl von Messungen wird es nur eine ungefähre Gleichheit geben X 0 . Es kann daher als realer Wert bezeichnet werden.

In allen praktischen Fällen der Wert X 0 ist unbekannt und es gibt nur eine gewisse Wahrscheinlichkeit dafür X 0 ist in einem Intervall nahe und es ist erforderlich, dieses Intervall entsprechend dieser Wahrscheinlichkeit zu bestimmen. Verwenden Sie als Schätzwert für den absoluten Fehler einer Einzelmessung D x ich = – x ich .

Es bestimmt die Genauigkeit einer gegebenen Messung.

Für eine Reihe von Messungen wird der arithmetische mittlere Fehler bestimmt

![]() .

.

Sie definiert die Grenzen, innerhalb derer mehr als die Hälfte der Dimensionen liegen. Somit, X 0 fällt mit hinreichend hoher Wahrscheinlichkeit in das Intervall von –h bis +h. Ergebnisse der Wertmessung X wird dann geschrieben als:

Wert X umso genauer gemessen, je kleiner das Intervall ist, in dem der wahre Wert liegt X 0 .

Absoluter Messfehler D x allein bestimmt noch nicht die Messgenauigkeit. Nehmen wir zum Beispiel an, dass die Genauigkeit eines Amperemeters 0,1 beträgt a. Strommessungen wurden in zwei Stromkreisen durchgeführt. In diesem Fall wurden folgende Werte erhalten: 320,1 a und 0.20.1 a. Aus dem Beispiel ist ersichtlich, dass zwar der absolute Messfehler gleich ist, aber die Messgenauigkeit unterschiedlich ist. Im ersten Fall sind die Messungen ziemlich genau, im zweiten lassen sie nur eine Beurteilung über die Größenordnung zu. Daher ist es bei der Bewertung der Qualität einer Messung notwendig, den Fehler mit dem gemessenen Wert zu vergleichen, was eine bessere Vorstellung von der Genauigkeit der Messungen gibt. Dazu das Konzept relativer Fehler

d x= D x /. (2.3)

Der relative Fehler wird üblicherweise in Prozent ausgedrückt.

Da die gemessenen Größen in den meisten Fällen eine Dimension haben, sind die absoluten Fehler dimensionsbehaftet und die relativen Fehler dimensionslos. Daher ist es mit Hilfe der letzteren möglich, die Genauigkeit von Messungen unterschiedlicher Größen zu vergleichen. Schließlich muss der Versuch so aufgebaut werden, dass der relative Fehler über den gesamten Messbereich konstant bleibt.

Es sollte beachtet werden, dass bei korrekt und sorgfältig durchgeführten Messungen der arithmetische mittlere Fehler ihres Ergebnisses nahe dem Fehler des gemessenen Instruments liegt.

Wenn die Messungen den gewünschten Wert haben X viele Male durchgeführt, dann die Häufigkeit des Auftretens eines bestimmten Werts X ich kann als Graph in Form einer Stufenkurve dargestellt werden - ein Histogramm (siehe Abb. 1), wobei beim ist die Anzahl der Lesungen; D x ich = X ich – x ich +1 (ichändert sich von - n bis + n). Mit zunehmender Anzahl der Messungen und abnehmendem Intervall D x ich das Histogramm verwandelt sich in eine kontinuierliche Kurve, die die Dichte der Wahrscheinlichkeitsverteilung des Wertes kennzeichnet x ich wird im Intervall D sein x ich .

|

Unter Zufallsvariable Verteilung die Gesamtheit aller möglichen Werte einer Zufallsvariablen und ihre entsprechenden Wahrscheinlichkeiten verstehen. Das Verteilungsgesetz einer Zufallsvariablen wird jede Entsprechung einer Zufallsvariablen mit den möglichen Werten ihrer Wahrscheinlichkeiten genannt. Die allgemeinste Form des Verteilungsgesetzes ist die Verteilungsfunktion R (X).

Dann die Funktion R (X) =R" (X) – Wahrscheinlichkeitsverteilungsdichte oder differentielle Verteilungsfunktion. Ein Wwird als Verteilungskurve bezeichnet.

Funktion R (X) ist dadurch gekennzeichnet, dass das Produkt R (X)dx es besteht die Wahrscheinlichkeit, dass es sich um einen separaten, zufällig ausgewählten Wert des Messwerts im Intervall ( X ,x + dx).

Im allgemeinen Fall kann diese Wahrscheinlichkeit durch verschiedene Verteilungsgesetze bestimmt werden (normal (Gauss), Poisson, Bernoulli, binomial, negativ binomial, geometrisch, hypergeometrisch, uniform diskret, negativ exponentiell). Meistens jedoch die Eintrittswahrscheinlichkeit des Wertes x ich in der Pause ( X ,x + dx) in physikalischen Experimenten werden durch das Normalverteilungsgesetz - das Gaußsche Gesetz - beschrieben (siehe Abb. 2):

, (2.4)

, (2.4)

wobei s 2 die Populationsvarianz ist. Durchschnittsbevölkerung Nennen Sie die Gesamtheit der möglichen Messwerte x ich oder mögliche Fehlerwerte D x ich .

Die weit verbreitete Verwendung des Gaußschen Gesetzes in der Fehlertheorie erklärt sich aus folgenden Gründen:

1) Absolut gleich große Fehler treten bei einer großen Anzahl von Messungen gleich häufig auf;

2) betragsmäßig kleine Fehler treten häufiger auf als große, d. h. die Wahrscheinlichkeit, dass ein Fehler auftritt, ist umso kleiner, je größer sein absoluter Wert ist;

3) Messfehler nehmen eine kontinuierliche Reihe von Werten an.

Diese Bedingungen werden jedoch nie strikt erfüllt. Experimente haben jedoch bestätigt, dass in dem Bereich, in dem die Fehler nicht sehr groß sind, das Normalverteilungsgesetz gut mit den experimentellen Daten übereinstimmt. Unter Verwendung des Normalgesetzes können Sie die Wahrscheinlichkeit eines Fehlers eines bestimmten Werts ermitteln.

Die Gaußsche Verteilung wird durch zwei Parameter charakterisiert: den Mittelwert der Zufallsvariablen und die Varianz s 2 . Der Mittelwert wird durch die Abszisse bestimmt ( X=) die Symmetrieachse der Verteilungskurve, und die Varianz zeigt, wie schnell die Wahrscheinlichkeit eines Fehlers mit zunehmendem Betrag abnimmt. Die Kurve hat ein Maximum ![]() beim X=. Daher ist der Durchschnittswert der wahrscheinlichste Wert der Größe X. Die Streuung wird durch die Halbwertsbreite der Verteilungskurve bestimmt, also den Abstand von der Symmetrieachse zu den Wendepunkten der Kurve. Sie ist das mittlere Quadrat der Abweichung der Ergebnisse einzelner Messungen von ihrem arithmetischen Mittel über die gesamte Verteilung. Wenn bei der Messung einer physikalischen Größe nur konstante Werte erhalten werden X=, dann s 2 = 0. Aber wenn die Werte der Zufallsvariablen X Nehmen Sie Werte ungleich , dann ist ihre Varianz ungleich Null und positiv. Die Streuung dient somit als Maß für Schwankungen der Werte einer Zufallsvariablen.

beim X=. Daher ist der Durchschnittswert der wahrscheinlichste Wert der Größe X. Die Streuung wird durch die Halbwertsbreite der Verteilungskurve bestimmt, also den Abstand von der Symmetrieachse zu den Wendepunkten der Kurve. Sie ist das mittlere Quadrat der Abweichung der Ergebnisse einzelner Messungen von ihrem arithmetischen Mittel über die gesamte Verteilung. Wenn bei der Messung einer physikalischen Größe nur konstante Werte erhalten werden X=, dann s 2 = 0. Aber wenn die Werte der Zufallsvariablen X Nehmen Sie Werte ungleich , dann ist ihre Varianz ungleich Null und positiv. Die Streuung dient somit als Maß für Schwankungen der Werte einer Zufallsvariablen.

Das Maß für die Streuung der Ergebnisse einzelner Messungen vom Mittelwert muss in denselben Einheiten ausgedrückt werden wie die Werte der Messgröße. In diesem Zusammenhang die Menge

namens mittlerer quadratischer Fehler .

Sie ist das wichtigste Merkmal der Messergebnisse und bleibt unter gleichen Versuchsbedingungen konstant.

Der Wert dieser Größe bestimmt die Form der Verteilungskurve.

Da die Fläche unter der Kurve zwar konstant (gleich Eins) bleibt, aber mit s ihre Form ändert, streckt sich die Verteilungskurve mit abnehmendem s in der Nähe des Maximums bei s nach oben. X=, und schrumpft in horizontaler Richtung.

Wenn s zunimmt, der Wert der Funktion R (X ich) nimmt ab und die Verteilungskurve erstreckt sich entlang der Achse X(siehe Abb. 2).

Bei einem Normalverteilungsgesetz der mittlere quadratische Fehler einer einzelnen Messung

, (2.5)

, (2.5)

und der mittlere quadratische Fehler des Mittelwerts

. (2.6)

. (2.6)

Der Effektivwert charakterisiert die Messfehler genauer als der arithmetische Mittelwert, da er sich recht streng aus dem Verteilungsgesetz zufälliger Fehlerwerte ergibt. Darüber hinaus macht seine direkte Verbindung mit der Varianz, deren Berechnung durch eine Reihe von Theoremen erleichtert wird, den mittleren quadratischen Fehler zu einem sehr bequemen Parameter.

Neben dem Dimensionsfehler s wird auch der dimensionslose relative Fehler d s =s/ verwendet, der wie d x, wird entweder in Bruchteilen einer Einheit oder in Prozent ausgedrückt. Das endgültige Messergebnis wird geschrieben als:

In der Praxis ist es jedoch unmöglich, zu viele Messungen vorzunehmen, sodass es unmöglich ist, eine Normalverteilung zu erstellen, um den wahren Wert genau zu bestimmen X 0 . In diesem Fall kann eine gute Annäherung an den wahren Wert betrachtet werden, und eine ziemlich genaue Schätzung des Messfehlers ist die Stichprobenstreuung, die sich aus dem Normalverteilungsgesetz ergibt, sich aber auf eine endliche Anzahl von Messungen bezieht. Dieser Name der Größe erklärt sich aus der Tatsache, dass aus der gesamten Menge von Werten X ich, d.h. die Allgemeinbevölkerung wird nur durch eine endliche Anzahl von Werten der Größe ausgewählt (gemessen). X ich(gleicht n), namens Probenahme. Die Stichprobe ist bereits durch den Stichprobenmittelwert und die Stichprobenvarianz charakterisiert.

Dann der mittlere quadratische Stichprobenfehler einer einzelnen Messung (oder empirischer Standard)

, (2.8)

, (2.8)

und der mittlere quadratische Stichprobenfehler einer Reihe von Messungen

. (2.9)

. (2.9)

Aus Ausdruck (2.9) ist ersichtlich, dass man durch Erhöhen der Anzahl von Messungen den mittleren quadratischen Fehler beliebig klein machen kann. Beim n> 10 wird eine merkliche Änderung des Wertes erst bei einer sehr signifikanten Anzahl von Messungen erreicht, daher ist eine weitere Erhöhung der Anzahl der Messungen nicht sinnvoll. Außerdem lassen sich systematische Fehler nicht vollständig eliminieren, und bei einem kleineren systematischen Fehler ist auch eine weitere Erhöhung der Versuchszahl nicht sinnvoll.

Somit ist das Problem des Auffindens eines ungefähren Werts einer physikalischen Größe und ihres Fehlers gelöst worden. Nun gilt es, die Zuverlässigkeit des gefundenen realen Wertes zu bestimmen. Unter Zuverlässigkeit von Messungen wird die Wahrscheinlichkeit verstanden, dass der wahre Wert in ein vorgegebenes Konfidenzintervall fällt. Intervall (– e,+ e), in dem der wahre Wert mit einer gegebenen Wahrscheinlichkeit liegt X 0, genannt Konfidenzintervall. Nehmen wir an, dass die Wahrscheinlichkeit des Unterschieds im Messergebnis X vom wahren Wert X 0 um einen Wert größer als e ist gleich 1 - a, d.h.

p(–e<X 0 <+ e) = 1 – a. (2.10)

In der Fehlertheorie wird e üblicherweise als die Größe verstanden. So

p (– <X 0 <+ ) = Ф(t), (2.11)

wo F ( t) ist das Wahrscheinlichkeitsintegral (oder Laplace-Funktion) sowie die Normalverteilungsfunktion:

, (2.12) wobei .

, (2.12) wobei .