Charkow russische Stadt. Es wurde in den 1630er Jahren gegründet. Dort ließen sich kleine Russen nieder, die vor den Polen vom rechten Ufer des Dnjepr geflohen waren. Zar Alexej Michailowitsch baute dort eine Festung und gründete 1656 die Woiwodschaft Charkow.

DNEPROPETROVSK - gegründet von Catherine - 2 im Jahr 1776 und hieß Jekaterinoslav.

SUMY - spätestens 1655 von Zar Alexei Michailowitsch gegründet. Der Zar erlaubte den kleinrussischen Flüchtlingen, die von den Polen getötet wurden, sich dort niederzulassen.

POLTAWA - war im 17. Jahrhundert das Zentrum des prorussisch gesinnten Kleinrusslands. Dafür überfiel der Verräter Hetman Vyhovsky die Stadt und verkaufte ihre Einwohner in die Sklaverei an die Krimtataren.

LUGANSK - gegründet 1795, als Katharina II. eine Eisengießerei am Fluss Lugan gründete. Um daran zu arbeiten, kamen Einwanderer aus den zentralen und nordwestlichen Provinzen Russlands nach Lugansk.

KHERSON - gegründet von Catherine - 2 im Jahr 1778 für den Bau der russischen Flotte. Der Bau wurde von Potemkin durchgeführt.

DONETSK - gegründet von Alexander - 2 im Jahr 1869 während des Baus eines Hüttenwerks in Yuzovka.

NIKOLAEV - gegründet von Catherine - 2 im Jahr 1789. Zu dieser Zeit baute Potemkin dort das Schiff St. Nikolaus.

ODESSA - gegründet von Catherine - 2 im Jahr 1794 an der Stelle einer Festung, die etwas früher von Suworow erbaut wurde.

Tschernigow - eine der ältesten russischen Städte, sie existierte zu Beginn des 10. Jahrhunderts. 1503 wurde er Teil Russlands. 1611 zerstörten die Polen es und nahmen dieses Gebiet den Russen ab. Aber 1654 kehrte Tschernigow nach Russland zurück und ist seitdem ein fester Bestandteil davon.

SIMFEROPOL - gegründet von Catherine - 2 im Jahr 1783 an der Stelle einer Festung, die zuvor von Suworow erbaut wurde. Baute die Stadt Potemkin.

MARIUPOL - gegründet 1778 von Katharina - 2 Sie siedelte dort Griechen an - Einwanderer von der Krim.

KRYVOY RIG - gegründet von Ekaterina - 2 im Jahr 1775. Und es erhielt seine industrielle Entwicklung während der Sowjetzeit als Basis der Metallurgie.

ZAPORIZHIA - gegründet von Catherine - 2 im Jahr 1770 und hieß Aleksandrovsk.

KIROVOGRAD - wurde 1754 von der russischen Kaiserin Elizaveta Petrovna als Festung zum Schutz der südlichen Grenzen des Russischen Reiches vor den Tataren gegründet. Es hieß ELISAVETHRAD.

KRIM - Beitritt der Krim zum Russischen Reich (1783) - Eingliederung des Territoriums des Krim-Khanats in Russland nach der Abdankung des letzten Krim-Khans Shahin Giray. 1784 wurde auf dem annektierten Gebiet die Taurische Region gebildet.

Und bereits im Frühjahr wurden dringend Maßnahmen ergriffen, um einen Hafen für die zukünftige Schwarzmeerflotte an der Südwestküste der Halbinsel auszuwählen. Katharina II. befahl durch ihr Dekret vom 10. Februar 1784, hier "einen Militärhafen mit einer Admiralität, einer Werft, einer Festung zu errichten und es zu einer Militärstadt zu machen". Anfang 1784 wurde eine Hafenfestung errichtet, der Katharina II. den Namen Sewastopol gab.

Am 28. Juni 1783 wurde das Manifest von Katharina II. schließlich während des feierlichen Eids des Krim-Adels veröffentlicht, der von Prinz Potemkin persönlich geleistet wurde.

Zuerst schworen Murzas, Beys, Geistliche Treue und dann die gewöhnliche Bevölkerung.

Die Feierlichkeiten wurden von Erfrischungen, Spielen, Pferderennen und Kanonenschüssen begleitet.

1 Grundlegende Konzepte und eine kurze Geschichte der Informatik

1.1 Grundbegriffe der Informatik

Im weitesten Sinne ist Informatik die Wissenschaft der Berechnung, Speicherung und Verarbeitung von Informationen, einschließlich Disziplinen im Zusammenhang mit Computertechnologie. Es ähnelt den englischen Begriffen Computer Science (Informatik) in den USA oder Computing Science (Informatik) in Großbritannien.

Die wichtigsten im Bereich der Informatik verwendeten Begriffe werden durch die zwischenstaatliche Norm GOST ISO / IEC 2382-99 „Informationstechnologien. Wörterbuch. Teil 1. Grundbegriffe. In Kraft getreten am 01.07.2000".

Das Folgende ist eine Zusammenfassung der in der Norm festgelegten Definitionen.

Information (in der Informationsverarbeitung) ist Wissen über Objekte wie Fakten, Ereignisse, Phänomene, Objekte, Prozesse, Darstellungen, einschließlich Konzepte, die in einem bestimmten Kontext eine bestimmte Bedeutung haben.

Informationen zeichnen sich durch folgende Eigenschaften aus:

1) Zuverlässigkeit;

2) Relevanz;

3) Vollständigkeit;

4) Kosten;

5) Volumen;

6) Art der Präsentation.

Daten - Informationen, die in einer formalisierten Form präsentiert werden, die für ihre Übertragung, Interpretation und Verarbeitung geeignet ist.

Text - eine Form der Datendarstellung in Form von Symbolen, Zeichen, Wörtern, Sätzen, Blöcken, Sätzen, Tabellen und anderen symbolischen Mitteln, die dazu bestimmt sind, Bedeutung zu vermitteln, deren Interpretation ausschließlich auf den Kenntnissen des Lesers über natürliche oder künstliche Sprachen basiert.

Datenverarbeitung - Leistung durch das System von Aktionen auf Informationen.

Automatische Datenverarbeitung – Ausführung von Aktionen mit Daten durch das System: arithmetische oder logische Operationen mit Daten, Kombinieren oder Sortieren von Daten, Übersetzen oder Kompilieren von Programmen oder Aktionen mit Text, wie z. B. Bearbeiten, Sortieren, Kombinieren, Speichern, Suchen, Anzeigen auf dem Bildschirm oder Druck.

Hardware(Hardware) - alle oder einen Teil der physischen Komponenten eines Informationsverarbeitungssystems. Zum Beispiel Computer, Peripheriegeräte.

Software ( Software) - alle oder Teile der Programme,

Verfahren, Regeln und zugehörige Dokumentation des Datenverarbeitungssystems. Hardware und Software facility - eine geordnete Sammlung von Befehlen und ähnlichem

damit Daten, die funktional unabhängig vom Hauptspeicher abgelegt werden, meist in Festwertspeichern.

Speicher (Speichergerät) ist ein funktionales Gerät, in dem Daten abgelegt, gespeichert und aus dem sie abgerufen werden können.

Automatisch – Bezieht sich auf einen Prozess oder eine Ausrüstung, die unter bestimmten Bedingungen ohne menschliches Eingreifen funktioniert.

Computerzentrum(Rechenzentrum) - Mittel, einschließlich Personal, Hardware und Software, die für die Bereitstellung von Iorganisiert sind.

Datenverarbeitungssystem(Computersystem) - ein oder mehrere Computer, Peripheriegeräte und Software zur Datenverarbeitung.

Informationsverarbeitungssystem- ein oder mehrere Datenverarbeitungssysteme und -geräte, wie z. B. Büro- oder Kommunikationsgeräte, die für die Informationsverarbeitung sorgen.

Informationssystem Das Informationsverarbeitungssystem, zusammen mit den zugehörigen organisatorischen Ressourcen, wie z. B. Personen, technischen und finanziellen Ressourcen, das Informationen bereitstellt und verteilt.

Funktionsdiagramm- ein Diagramm eines Systems, in dem die Hauptteile oder Funktionen durch Blöcke dargestellt werden, die durch Linien verbunden sind, die die Beziehung zwischen den Blöcken zeigen.

auf Funktionen, physikalische Wechselwirkungen, Signalaustausch und andere ihnen innewohnende Eigenschaften.

Datenaustausch – die Übertragung von Daten zwischen funktionalen Geräten in Übereinstimmung mit einer Reihe von Regeln für die Datenbewegungskontrolle und Austauschaushandlung.

funktionsfähiges Gerät- ein Element aus Hardware und Software oder Software und Hardware, das zur Ausführung einer bestimmten Aufgabe entwickelt wurde.

Virtuell - die Definition eines funktionalen Geräts, das real erscheint, dessen Funktionen jedoch auf andere Weise ausgeführt werden.

Ein Datenträger ist ein materieller Gegenstand, in oder auf den Daten geschrieben und von dem sie gelesen werden können.

Verarbeitungsgerät - Eine funktionelle Einheit, die aus einem oder mehreren besteht

Prozessoren und deren internen Speicher.

Computer - Ein funktionales Gerät, das komplexe Berechnungen, einschließlich einer großen Anzahl von arithmetischen und logischen Operationen, ohne menschliches Eingreifen durchführen kann.

Digitaler Computer - ein Computer, der von Programmen gesteuert wird, die im internen Speicher gespeichert sind und den gemeinsamen Speicher für alle oder einen Teil der Programme sowie für alle oder einen Teil der für die Ausführung von Programmen erforderlichen Daten verwenden können; Ausführen von Programmen, die vom Benutzer geschrieben oder angegeben wurden; benutzerdefinierte Manipulationen an als Zahlen dargestellten diskreten Daten durchführen, einschließlich arithmetischer und logischer Operationen, und Programme ausführen, die während der Ausführung modifiziert werden.

1.2 Kurze Geschichte der Entwicklung der Informationstechnologie

Die Geschichte der Entwicklung informationstechnischer Werkzeuge ist eng mit der Entwicklung der Wissenschaft verbunden. Bei der Entwicklung der Informationstechnologien gibt es drei Richtungen:

1) Verbesserung der Hardware;

2) Entwicklung der Theorie der Informatisierung, Algorithmisierung und Programmierung;

3) Aufbau des Informationsraumes mittels Telekommunikation.

1.2.1 Hardwareentwicklung

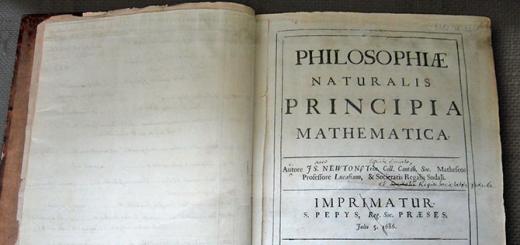

Schon in der Antike wurden mechanische Geräte geschaffen, um die Durchführung numerischer Berechnungen zu erleichtern: alle Arten von mechanischen Berechnungen. Am Ende des Mittelalters wurden mechanische Computer geschaffen – Rechenmaschinen. Alle diese Geräte werden bedingt als mechanische Computer der Nullgeneration bezeichnet. Die Dauer dieser Phase reicht vom alten Ägypten bis zur Mitte des 20. Jahrhunderts. Gleichzeitig wurden mechanische Geräte zur Automatisierung von Rechenoperationen eingesetzt: Mengen, mechanische Arithmometer und Rechenschieber.

Abbildung 1.1 - Das aktuelle Modell eines mechanischen Computers von Charles Babbage

Die Schaffung vollwertiger programmierbarer Computer wurde jedoch erst mit der Entwicklung der Funkelektronik, Mathematik und Informationstheorie möglich.

Abbildung 1.2 – Mechanische Geräte: Rechenmaschine und Rechenschieber Die Geschichte der Verbesserung der Hardware wird herkömmlicherweise in 5 Phasen unterteilt:

Relais. Computer dieser Stufe sollten wissenschaftliche Berechnungen durchführen, normalerweise im militärischen Bereich.

Abbildung 1.3 - Vakuumröhre und elektrisches Relais Vor dem Zweiten Weltkrieg tauchten sie auf und wurden in wissenschaftlichen Berechnungen verwendet

mechanische und elektrische Analogrechner. Insbesondere physikalische Phänomene wurden auf analogen Computern durch die Werte der elektrischen Spannung und des Stroms modelliert. Die ersten digitalen Computer oder elektronischen Computer (Computer) erschienen während des Zweiten Weltkriegs.

Der erste funktionierende Prototyp des Z1-Computers wurde 1938 vom Deutschen Konrad Zuse (deutsch: Konrad Zuse) entwickelt. Es war ein elektrisch betriebener binärer mechanischer Rechner mit eingeschränkter Tastaturprogrammierung. Das Ergebnis der Berechnungen im Dezimalsystem wurde auf dem Lampenfeld angezeigt. Der nächste Zuse-Z2-Computer wurde auf Telefonrelais umgesetzt und las Anweisungen von perforiertem 35-mm-Film. 1941 baut Zuse den ersten funktionsfähigen programmierbaren Computer, den Z3, der zur Konstruktion eines Flugzeugflügels verwendet wurde. Z1, Z2 und Z3 wurden bei der Bombardierung Berlins 1944 zerstört).

Abbildung 1.4 - Rechner Z1 und Rekonstruktion des Rechners Z3

1943 baute International Business Machines (IBM) den ersten Computer für die US Navy. Entworfen von Wissenschaftlern in Harvard

Universität unter der Leitung von Howard Aiken und mit dem Namen "Mark-1". Es wurde auf der Grundlage der Harvard-Architektur mit elektromechanischen Relais gebaut, das Programm wurde von Lochstreifen eingegeben. Der Computer maß 2 Meter hoch und 15 Meter lang.

Abbildung 1.5 - Mark-1- und Colossus-Computer

Im Dezember 1943 wurde in Großbritannien der britische Computer Colossus entwickelt – das erste vollelektronische Rechengerät, das entwickelt wurde, um geheime Nachrichten zu entschlüsseln, die mit deutschen Enigma-Maschinen verschlüsselt wurden. Zehn Kolosse wurden gebaut, aber alle wurden nach dem Krieg zerstört. 1943 wurde damit begonnen

Siliziumdioden, 1.500 Relais, 70.000 Widerstände und 10.000 Kondensatoren (ca. 6 m hoch und 26 m lang), hatten eine Leistung von 5000 Operationen pro Sekunde beim Additionstyp und 360 beim Multiplikationstyp und kosteten zu diesem Preis 2,8 Millionen Dollar Zeit. Stromverbrauch - 150 kW. Rechenleistung - 300 Multiplikationen oder 5000 Additionen pro Sekunde. Gewicht - 27 Tonnen. Es wurde im Auftrag der US-Armee am Ballistic Research Laboratory zur Berechnung von Schießtabellen gebaut. Wird für Berechnungen bei der Herstellung der Wasserstoffbombe verwendet. Der Computer wurde zuletzt 1955 eingeschaltet. ENIAC diente als Prototyp für die Erstellung aller nachfolgenden Computer.

Die Entwicklung der ersten elektronischen Serienmaschine UNIVAC (Universal Automatic Computer) wurde 1947 von Eckert und Mauchli begonnen, die im Dezember desselben Jahres die Firma ECKERT-MAUCHLI gründeten. Der erste UNIVAC-1-Computer wurde im Frühjahr 1951 für das US Census Bureau in Betrieb genommen. Sie arbeitete mit einer Taktfrequenz von 2,25 MHz und enthielt etwa 5000 Elektronenröhren. 1952 veröffentlichte IBM seinen ersten industriellen elektronischen Computer, den IBM 701, einen synchronen Parallelcomputer mit 4.000 Vakuumröhren und 12.000 Germaniumdioden.

BEI 1949 gründete Konrad Zuse in der Stadt Hünfeld (Deutschland) die Firma Zuse KG und vollendete im September 1950 die Arbeit am Z4-Computer (der einzige funktionierende Computer in Kontinentaleuropa in jenen Jahren), der zum weltweit ersten verkauften Computer wurde: fünf Monate vor dem Mark I und zehn UNIVACs. Die Firma Zuse stellte Computer her, deren Name jeweils mit dem Buchstaben Z begann. Die bekanntesten Maschinen waren die Z11, die an die optische Industrie und Universitäten verkauft wurde, und die Z22, der erste Computer mit Magnetspeicher.

BEI 1945 SA Lebedev schuf den ersten elektronischen Analogcomputer in der UdSSR zum Lösen von Systemen gewöhnlicher Differentialgleichungen, die bei Problemen der Elektrotechnik auftreten. Seit Herbst 1948 in Kiew, S.A. Lebedev begann mit der Entwicklung der Small Electronic Computing Machine (MESM). 1950 wurde MESM in einem zweistöckigen Gebäude des ehemaligen Klosters in Feofaniya bei Kiew installiert.

In der zweiten Hälfte der 1950er Jahre in Minsk unter der Leitung von G.P. Lopato und V.V. Przhyyalkovsky begannen die Arbeiten an der Schaffung der ersten belarussischen Computer der Familie Minsk-1 in der Computer Machinery Plant in verschiedenen Modifikationen: Minsk-1, Minsk-11, Minsk-12, Minsk-14. Die durchschnittliche Leistung der Maschine betrug 2000 - 3000 Operationen pro Sekunde.

BEI Bei den Computern der ersten Generation zeigte sich ein Widerspruch zwischen der hohen Geschwindigkeit der zentralen Geräte und der niedrigen Geschwindigkeit und Unvollkommenheit externer Geräte. Das erste Speichermedium in Computern war eine Lochkarte und Lochstreifen oder einfach Lochstreifen. Speichervorrichtungen wurden auf Ferritringen implementiert, die auf Drahtmatrizen aufgereiht waren.

Abbildung 1.6 - Datenträger von Computern der ersten Generation: Lochkarte und Lochstreifen Die zweite Stufe in der Entwicklung von Computern ist die Ablösung elektronischer Computer im Design

Lampen für Halbleitergeräte. Es begann in der zweiten Hälfte der 1950er Jahre. (Am 23. Dezember 1947 erfanden William Shockley, Walter Bratain und John Bardeen in den Bell Labs den Punkt-Bipolartransistor-Verstärker.) Dies ermöglichte es, die Gewichts-, Größen-, Kosten- und Energieindikatoren von Computern zu reduzieren und ihre technischen Eigenschaften zu verbessern.

Leistung von 250.000 Operationen pro Sekunde. In diesen Jahren erschien eine neue Art von Computern, die zur Steuerung technologischer Prozesse entwickelt wurden und als Steuercomputer (CCM) - Industriecomputer bezeichnet wurden. Merkmale dieser Klasse von Computern ist die Arbeit in Echtzeit. Computer wurden für die zentrale Datenverarbeitung im Finanzsektor eingesetzt.

1956 entwickelte IBM in der Luft schwebende Magnetköpfe.

RAMAC. Letzteres hatte eine Packung mit 50 magnetisch beschichteten Metallscheiben, die sich mit 12.000 U / min drehten.

1963 erfand Douglas Engelbart die Computermaus - ein Gerät zur Eingabe von Maßinformationen.

Am 4. Juni 1966 erhielt Robert Dennard von IBM ein Patent für eine Ein-Transistor-Speicherzelle (DRAM Dynamic Random Access Memory) und für die Grundidee einer 3-Transistor-Speicherzelle zur Kurzzeitspeicherung von Informationen ein Computer.

Abbildung 1.8 - Laufwerk und der erste Computer "Maus" Die dritte Stufe - der Einsatz von Technologie bei der Herstellung von Computern

Integrierte Schaltkreise (ICs), die 1958 von Jack Kilby von Texas Instruments und Robert Noyce von Fairchild Semiconductor unabhängig voneinander erfunden wurden. Begonnen in der zweiten Hälfte der 1960er Jahre. Gleichzeitig stellte sich mit der steigenden Anzahl von Computern die Frage nach deren Software-Kompatibilität. Computer der dritten Generation hatten nicht nur verbesserte technische und wirtschaftliche Indikatoren, sondern wurden auch unter Verwendung von hergestellt

Baukastenprinzip von Hard- und Software. Computer der dritten Generation konnten Daten nicht nur in Form von Zahlen, sondern auch in Form von Zeichen und Textzeilen verarbeiten.

Abbildung 1.9 - Integrierte Schaltkreise Der Beginn der Ära der Computer der dritten Generation war die Ankündigung am 7. April 1964.

von IBM des Universalcomputers IBM System/360. Seine Entwicklung kostete zu damaligen Preisen 5 Milliarden US-Dollar. Er war der Prototyp der EG-Computerserie der RGW-Mitgliedsländer, deren Produktion 1972 begann. Gleichzeitig entstanden verschiedene Klassen von Computern: Kleincomputer, Minicomputer, Desktop-Computer, Supercomputer. Die Klasse der Steuerungscomputer (CCMs), heute Industriecomputer und Controller genannt, entwickelte sich sowohl unabhängig als auch zusammen mit anderen Computern.

Abbildung 1.10 - Computer der dritten Generation IBM System / 360

DEC schuf den ersten kommerziellen Mini-Computer PDP-1 (in der Größe eines Autos) mit einem Monitor und einer Tastatur, der 120.000 US-Dollar kostete. Tatsächlich war der PDP-1 die erste Gaming-Plattform für das Computerspiel Star War, das vom MIT-Studenten Steve Russell geschrieben wurde.

Die vierte Stufe ist mit der Entwicklung der Technologie für große integrierte Schaltungen (LSI) und einer neuen Klasse elektronischer Prozessoren - Mikroprozessoren - verbunden. Der erste Mikroprozessor wurde von Intel i4004 am 15. November 1971 für Taschenrechner der japanischen Firma Nippon Calculating Machine, Ltd entwickelt und kostete 200 Dollar. Es wurde möglich, die technischen Eigenschaften von Computern qualitativ zu verbessern und ihre Kosten stark zu senken. In der zweiten Hälfte der 70er Jahre begann die Produktion von Computern der vierten Generation.

Abbildung 1.11 - - Der erste Mikroprozessor Intel 4004

Ende der 70er Jahre des 20. Jahrhunderts begannen Entwicklungen zur Schaffung neuer Mikrochips mit sehr hohem Integrationsgrad (VLSI) für Computersysteme, die nicht nur alphanumerische Daten, sondern auch Daten in Form von Ton- und Videobildern verarbeiten.

Computer wurden verwendet, um deterministische Datenverarbeitungssysteme zu erstellen. Das Aufkommen von Mikroprozessoren führte zur Entstehung einer neuen Klasse von Computern, die derzeit am weitesten verbreitet ist - ein Personal Computer (PC oder PC). Der erste derartige Computer, der Altair 8800, wurde von entwickelt

Micro Instrumentation and Telemetry System (Albuquerque, USA) im Jahr 1975

Abbildung 1.12 - Der erste Personal Computer (PC) Altair 8800

Der PC spielt eine besondere Rolle bei der massenhaften Verbreitung der Computertechnologie im gesellschaftlichen Bereich. Der erste wirklich massenproduzierte Apple-II-Personalcomputer wurde von Apple Computer (USA) hergestellt, das 1977 von Steve Wozniak und Steve Jobs gegründet wurde, und kostete 1.298 US-Dollar. In der UdSSR wurde Mitte der 80er Jahre des 20. Jahrhunderts sein Analogon unter dem Namen "Agat" hergestellt. Der Computer hatte einen Farbmonitor, ein Laufwerk (zuverlässiger und schneller als der zuvor verwendete Kassettenrekorder) und eine Software, die für einen einfachen Benutzer entwickelt wurde.

Abbildung 1.13 - Der erste serielle PC Apple-II

Der erste mobile NoteTaker-PC (Prototyp eines Laptops) wurde 1976 im kalifornischen PARC Center entwickelt. Es enthielt einen Prozessor mit einer Taktfrequenz von 1 MHz, 128 KB RAM, ein eingebautes monochromes Display, ein Diskettenlaufwerk (Diskettenlaufwerk) und eine Maus. Die als Betriebssystem verwendete Version

Abdeckung, die den Monitor und das Diskettenlaufwerk bedeckte. NoteTaker wog 22 kg und konnte autonom (von Batterien) arbeiten. Insgesamt wurden etwa 10 Prototypen hergestellt.

Abbildung 1.14 – Der erste Prototyp des NoteTaker-Laptops

BEI 1977 wurde der erste Multiprozessorkomplex in der UdSSR entwickelt"Elbrus-1" (15 Millionen Operationen pro Sekunde), dessen Architekturideologe Boris Artashesovich Babayan war.

BEI 1978 führte Seiko Epson den Nadeldrucker ein Der TX-80 hat einen neuen Standard für kostengünstige Hochleistungsdrucker gesetzt.

PCs sind seit 1981 weit verbreitet, als der IBM PC 5150 entwickelt wurde.

basierend auf dem Mikroprozessor Intel 8088, kostet 3.000 US-Dollar - der erste PC dieser Serie, der mit Microsoft-Softwaresystem ausgestattet ist. In den Jahren 1981-1985 verkaufte IBM mehr als 1 Million PCs und erwartete zunächst 250.000, die in einem ersten Monat ausverkauft waren. Ein Merkmal dieses PCs war die Verwendung des Prinzips der offenen Architektur. Dank dessen begannen viele Firmen, Computer dieser Art herzustellen, was die Preise stark senkte und Computer nicht nur Firmen, sondern auch Privatpersonen zur Verfügung stellte. Für diese Klasse von Computern wurden neue Arten von Peripheriegeräten entwickelt, die es ihnen ermöglichen, in einem Büroautomationssystem verwendet zu werden, vereinheitlichte verteilte Informationsrechennetzwerke zu schaffen und einen PC als Kommunikationsmittel zu verwenden.

Im März 1979 wurde während der Veranstaltung „Optical Digital Audio Disc Demo" im niederländischen Eindhoven der erste Prototyp vorgestellt. Der CD-Prototyp namens Pinkeltje sollte die damals auf dem Markt befindlichen populären Musikplatten ersetzen.

Abbildung 1.15 - Personal Computer IBM PC 5150

Am 7. Mai 1984 brachte Hewlett-Packard (USA) den ersten Laserdrucker der LaserJet-Serie mit einer Produktivität von 8 Seiten pro Minute bei einer Auflösung von 300 dpi für 3.500 $ und einem Preis pro Seite von 0,041 $ auf den Markt.

1982 brachte Hewlett-Packard den ersten Taschencomputer auf den Markt – den HP-75 Organizer mit einer einzeiligen Flüssigkristallanzeige, 16 KB RAM (plus 48 KB ROM). Ergänzt wurde die Ausstattung durch eine recht große Tastatur (ohne separaten Ziffernblock), sowie einen Magnetkartenleser, einen Speichererweiterungsslot und eine HP-IL-Schnittstelle zum Anschluss von Druckern, externen Laufwerken etc. Das Gerät war mit einem BASIC-Sprachinterpreter und einem Texteditor ausgestattet.

Abbildung 1.16 - Der erste Taschencomputer - Organizer HP-75

Die fünfte Phase begann Ende der 80er und Anfang der 90er Jahre des 20. Jahrhunderts und ist mit der technologischen Verbesserung aller Computerkomponenten und der Kostensenkung verbunden, was die Schaffung mobiler Computer und die Masseneinführung von Computern in allen Bereichen des menschlichen Lebens ermöglichte: Produktion, Bildung, Medizin, Finanzen, Kommunikation, Erholung und Unterhaltung. Auf dem Markt erschienen neue Typen externer Speicher: CD-RW-Datenträger, Speicherkarten. Computernetzwerke wurden nicht nur von Spezialisten, sondern auch von normalen Benutzern verwendet.

Es sind neue Eingabe-/Ausgabegeräte erschienen, die auf elektronischen Flash-Speicherchips basieren. 1988 brachte Intel den ersten in Massenproduktion hergestellten 256-KB-NOR-Flash-Speicherchip für 20 US-Dollar auf den Markt.

Computer der fünften Generation sind für einen einfachen Benutzer ohne besondere Ausbildung konzipiert.

Im Jahr 2000 entwickelte IBM den Supercomputer der Serie RS/6000 SP – ASCI White (Accelerated Strategic Computing Initiative White Partnership) – mit einer Leistung von über 10 TFLOPS, einer Spitzenleistung von 12,3 TFLOPS. ASCI White besteht aus 512 Computern, die miteinander verbunden sind und die Fläche von zwei Basketballplätzen abdecken. Der Computer wurde für das Lawrence Livermore National Laboratory des US-Energieministeriums entwickelt, um Atomexplosionen zu simulieren und gelagerte Atomwaffen zu kontrollieren.

1.2.2 Entwicklungsgeschichte der Informationstechnik und Programmierung

Aus Sicht der Entwicklung der Informationstechnologie in der Geschichte der Computertechnologie gibt es vier Stufen.

Die erste Phase (40 - 60er Jahre des 20. Jahrhunderts) ist mit großen Einschränkungen der Maschinenressourcen von Computern der 1. Generation verbunden und spielt daher beim Kompilieren von Programmen eine besondere Rolle

Schalter, aber das gilt nur für kleine Programme.

Als nächstes wurde eine Maschinensprache (Maschinencodes) entwickelt, mit deren Hilfe es möglich wurde, Befehle zu setzen, indem man mit Speicherzellen arbeitet und die Fähigkeiten der Maschine voll ausnutzt. Seine Verwendung für die meisten Computer war jedoch sehr schwierig, insbesondere beim Programmieren von E / A, und verschiedene Prozessoren weisen Unterschiede im Satz von Maschinenbefehlen auf. Dies führte zur Entstehung von maschinenorientierten Assemblersprachen, die anstelle von Maschinenanweisungen mnemotechnische Anweisungen verwenden. Um den Prozess der Codierung von Rechenalgorithmen zu vereinfachen und zu beschleunigen, wurden die algorithmischen Programmiersprachen ALGOL und FORTRAN entwickelt.

Der UNIVAC-1103-Computer war der erste, der Software-Interrupts verwendete. Mitarbeiter von Remington-Rand verwendeten eine algebraische Form von Schreibalgorithmen namens "Short Cocle". US-Navy-Offizier und Leiter einer Gruppe von Programmierern, Captain (später die einzige Frau im US-Navy-Admiral) Grace Hopper, entwickelte 1951 das erste Compiler-Programm. Level-Programmiersprache Fortran oder FORTRAN (von Phrasen-Formel-Übersetzer).

Die zweite Phase (Mitte der 60er - Anfang der 80er Jahre des 20. Jahrhunderts) ist mit der Einsparung von Humanressourcen verbunden. Gleichzeitig fand ein Übergang von der Technologie der effektiven Nutzung von Programmen zur Technologie der effektiven Programmierung statt. Bei der Entwicklung von Programmiersystemen kam der Einsparung von Personalressourcen eine besondere Rolle zu. Es wurden höhere Programmiersprachen erstellt. Sie ähneln natürlichen Sprachen und verwenden gesprochene englische Wörter und mathematische Symbole. Diese Sprache wurde jedoch schwierig, die Entwicklung großer Programme zu kontrollieren. Die Lösung für dieses Problem kam nach der Erfindung der strukturierten Programmiersprachentechnologie. Sein Wesen liegt in der Möglichkeit, das Programm in seine Bestandteile zu zerlegen.

Es wurden auch funktionale (anwendungsbezogene) Sprachen erstellt (Beispiel: Lisp - Englisch.

LISt Processing, 1958) und logische Sprachen (Beispiel: Prolog - English PROgramming in LOGic, 1972).

BEI 1964 entwickelten John Kemeny und Thomas Kürtz am Dartmouth College die Programmiersprache BASIC (Beginners Allzweck-Symbolic Instruction Code oder Multipurpose Symbolic Instruction Code Language for Beginners). Die American Standards Association verabschiedet einen neuen 7-Bit-Standard für ASCII (American Standard Code for Information Interchange).

Die Programmiersprache Pascal wurde 1969 von Niklaus Wirth für die Erstausbildung des Programmierens geschaffen.

1969 wurde die Originalversion der Texte in den Bell Laboratories erstellt.

UNIX-Betriebssystem mit der Programmiersprache C.

1974 Digital Research entwickelte das Betriebssystem CP / M, das zur Basis für PCs wurde, die auf 8-Bit-Intel 8080- und Zilog Z-80-Mikroprozessoren basierten.

Niklaus Wirth entwickelte 1977 die Programmiersprache Modula und 1978 deren Weiterentwicklung Modula-2.

BEI 1978 gründete Seymour Rubinstein MicroPro International, die eines der ersten hochwertigen Word Master-Textverarbeitungsprogramme enthielt.

BEI 1980 erschienen die ersten VisiCalc-Tabellenkalkulationen von Ray Ozzy, die es normalen Benutzern ermöglichten, Berechnungen ohne Kenntnisse einer Programmiersprache durchzuführen.

BEI 1981 Betriebssystem erstellt MS-DOS 1.0 von Microsoft für die IBM PC-Serie.

Die dritte Stufe (von Anfang der 80er bis Mitte der 90er Jahre des 20. Jahrhunderts) - Formalisierung

Wissen. Bis zu diesem Zeitpunkt arbeiteten nur Spezialisten auf dem Gebiet der Programmierung mit einem Computer, dessen Aufgabe es war, formalisiertes Wissen zu programmieren. Während der 30-jährigen Nutzung der Computertechnologie stellte sich heraus, dass ein erheblicher Teil des in den letzten 300 Jahren auf dem Gebiet der exakten Wissenschaften angesammelten Wissens im externen Speicher eines Computers gespeichert war. Ende 1983 waren 90 Prozent der Computernutzer keine professionellen Programmierer mehr.

Strukturierte Programmierung scheiterte, wenn die Programme eine bestimmte Größe und Komplexität erreichten. In den späten 1970er und frühen 1980er Jahren wurden die Prinzipien der objektorientierten Programmierung (OOP) entwickelt. SmallTalk war die erste OOP-Sprache. Weiterhin wurden C++ und Object Pascal (Delphi) entwickelt. Mit OOP können Sie Programme optimal organisieren, indem Sie das Problem in seine Bestandteile zerlegen und mit jedem einzeln arbeiten. Ein Programm in einer objektorientierten Sprache, das ein bestimmtes Problem löst, beschreibt tatsächlich den Teil der Welt, der mit diesem Problem zusammenhängt.

BEI 1984 entwickelte die Westlake Data Corporation den ersten PathMinder-Dateimanager, eine multifunktionale Shell für DOS.

BEI 1985 erschien die erste Version des Layoutprogramms Aldus PageMaker.

BEI 1985 entwickelte SEA den ersten ARC-Archivierer.

1986 wurde der Dateimanager Norton Commander 1.0 für DOS von Peter Norton Computing (später von Symantec übernommen) entwickelt.

BEI 1986 entwickelte Larry Wall die Skriptsprache Perl.

BEI Im Oktober 1987 wurde die erste Version der Microsoft Excel-Tabelle erstellt.

BEI Im Dezember 1988 wurde die erste Version von Word für Microsoft Windows veröffentlicht.

BEI Im Dezember 1989 wurde die erste Version von Adobe Photoshop entwickelt.

Am 22. Mai 1989 wurde die Betriebssystemumgebung Microsoft Windows 3.0 veröffentlicht, die kein eigenständiges Betriebssystem ist, sondern nur ein Add-on zu MS-DOS. Mitte 1989 wurde die erste Version des beliebten Grafikpakets CorelDRAW veröffentlicht.

BEI 1990 Microsoft entwickelt die Programmiersprache Visual Basic.

BEI Im September 1991 wurde die erste Version des freien Betriebssystems Linux 0.01 vom finnischen Studenten Linus Torvalds veröffentlicht.

BEI 1992 wurde der Standard geschaffen MPEG-1, das 3 Ebenen der Audiodatencodierung definiert (die dritte Ebene entspricht der besten Qualität).

BEI November 1993 wurde die Betriebsumgebung Microsoft Windows für Workgroups veröffentlicht

Im Herbst 1994 wurde IBM OS/2 Warp 3.0 veröffentlicht.

BEI Ende 1994 wurde ein Standard zum Kodieren und Verpacken von Videodaten verabschiedet MPEG-2. Die vierte Phase (beginnend Mitte der 90er Jahre des 20. Jahrhunderts) hängt damit zusammen, dass Computer in

hauptsächlich von ungelernten Benutzern verwendet, hat dies zu einfachen, intuitiven Schnittstellen geführt. Computer haben sich von einem Computermittel zu einem Mittel der Telekommunikation und einem Mittel der Unterhaltung entwickelt.

24. August 1995 Ankündigung von Microsoft Windows 95 mit einer neuen intuitiven Benutzeroberfläche. Gleichzeitig wurde die Office-Suite Microsoft Office 95 veröffentlicht.

Im September 1995 kündigte IBM das Betriebssystem OS/2 Warp Connect 4.0 an. Die Verwendung klassischer Programmiersysteme zur Entwicklung einer modernen Anwendungsprogrammschnittstelle ist für den Entwickler zu zeitaufwändig geworden, um ihre Beschreibung zu schreiben. Was zur Schaffung visueller Programmiersysteme oder Accelerated Development Systems (RAD-Systeme) führte, die den für die Benutzeroberfläche verantwortlichen Teil des Programmcodes automatisch generierten. 1995 veröffentlichte Borland die Borland Delphi 1.0 Accelerated Application Development Environment (RAD) basierend auf der Programmiersprache Object Pascal für die Windows 3.11-Umgebung. 1996 wurde die erste Version des RAD-Systems für

Programmiersprache C++ Borland C Builder.

BEI 1996 veröffentlichte Microsoft Windows NT 4.0 mit einer Schnittstelle ähnlich der von Windows 95 und Unterstützung für PnP-Hardware-Autokonfigurationstechnologie.

BEI Im Dezember 1999 wurde Microsoft Office 97 veröffentlicht.

BEI Im Juli 1998 wurde das PC-Betriebssystem Microsoft Windows 98 veröffentlicht.

BEI Im Dezember 1999 wurden die Office-Suite Microsoft Office 2000 und das Betriebssystem Microsoft Windows 2000 der nächsten Generation angekündigt, das Windows 9x und kombinierte

Manchmal sieht man sich um und es scheint, dass die moderne Welt außerhalb der IT nicht existiert. Es gibt jedoch Bereiche des menschlichen Lebens, die nur sehr schwach von der Computerisierung betroffen sind. Ein solcher Bereich ist die Geschichte. Sowohl als Wissenschaft als auch als Studiengang. Natürlich wird die Arbeit am Computer wahrscheinlich nie Historiker ersetzen, die in Archiven stöbern. Aber die Geschichte anhand der im Lehrbuch gezeichneten statischen Karten zu studieren und die Reihenfolge der Ereignisse zu erstellen, Daten sorgfältig in aufsteigender Reihenfolge auf ein Blatt Papier zu schreiben - dies ist definitiv das letzte Jahrhundert. Es gibt jedoch nicht so viele Werkzeuge für das visuelle Studium der Geschichte und es ist sehr schwierig, sie zu finden.

Wenn Sie wissen möchten, was interaktive historische Karten sind, wo Sie nach zeitlichen Darstellungen von Ereignissen suchen und wie Sie komplexe Wikipedia-Abfragen wie „alle Staatsmänner, die 1725 in Europa tätig waren“ durchführen können, lesen Sie weiter.

Wie alles begann: In der Sommerschule haben wir uns vorgenommen, eine interaktive Karte historischer Ereignisse auf Basis von Wikipedia zu erstellen. Ich gebe keinen direkten Link zum Projekt, weil das Projekt sehr roh ist (ein Team von 4 hervorragenden Zehntklässlern hat daran gearbeitet, aber wie viel kann man in 3 Wochen schaffen), und auch, weil der Server dazu neigt, „abzustürzen ” ohne Habraeffekt.

Wir wollten auf der Karte die Ereignisse anzeigen, die in verschiedenen historischen Epochen stattgefunden haben - und das hat teilweise geklappt: Wir haben eine Karte der Schlachten mit ihren Beschreibungen. Als wir dieses Projekt durchführten, kannten wir nur ein paar interaktive historische Atlanten, und keiner von ihnen zeigte Ereignisse auf der Karte.

Ich glaube, dass es so wenige dieser Karten gibt, weil alle vor denselben Problemen stehen wie wir: Historische Daten sind nicht strukturiert. Es gibt keine maschinenlesbaren Datenbanken, aus denen Informationen zu wichtigen historischen Ereignissen heruntergeladen werden können. Historiker, wenn sie Datenbanken erstellen, beschreiben darin in der Regel nur ihr enges Themengebiet – etwa Karten der Befestigungsanlagen des Römischen Reiches. Dies mag für Historiker interessant und nützlich sein, aber es ist unwahrscheinlich, dass gewöhnliche Menschen viel Nutzen aus einer solchen Karte ziehen können. Das zweite Problem ist der völlige Mangel an Daten über die Grenzen von Ländern in historischer Perspektive. Sie können Hunderte von Atlanten antiker Epochen finden, aber Sie müssen die Koordinaten der Grenzen manuell aus den Atlanten übertragen. Das dritte Problem ist das Fehlen jeglicher Standards zur Beschreibung historischer Daten. Es gibt nicht einmal ein normales Format zur Beschreibung eines Datums; Standarddatentypen und -formate brechen über BC zusammen. Was können wir über unterschiedliche Kalender oder ungenaue Daten sagen? ..

Die Probleme des Mangels an maschinenlesbaren historischen Daten warten noch darauf, gelöst zu werden (wir arbeiten daran, machen Sie mit, es gibt genug Arbeit für alle). Trotzdem bewältigen einige Projekte dies auf ihre eigene Weise ...

Wie die Volksweisheit sagt: "Nachdem Sie das Gerät kaputt gemacht haben, studieren Sie die Anweisungen." Nachdem wir unsere Karte erstellt hatten, gelang es mir, mehrere andere Projekte mit interaktiven Karten und anderen Möglichkeiten zu finden, die Geschichte zu visualisieren und historische Daten zu extrahieren. Aber ich brauchte eine völlig unanständige Zeit, um diese Ressourcen in den Eingeweiden des Internets auszugraben, also beschloss ich, alles, was ich fand, an einem Ort zu sammeln.

Die erste Kategorie - Interaktive historische Karten. Das sind nicht die Karten meiner Träume, aber durchaus funktionierende Produkte. Es gibt einige davon (und ich zähle hier nicht die hochspezialisierten auf), aber leider nur ein paar wirklich gute. Unabhängig davon ist es traurig, dass es unter ihnen keine lokalisierten Projekte gibt, was bedeutet, dass es schwierig ist, russischsprachigen Schulkindern beizubringen, sie zu verwenden.

- Die niedlichste Karte und sogar eine mit sehr breiten Visualisierungsmöglichkeiten ist Chronas. Es ist ein bisschen schwierig, es alleine zu lernen, also schau es dir an Videoclipüber seine Möglichkeiten. Es ist schön und stark. Historische Ereignisse verschiedener Art sind auf der Karte mit unterstützenden Informationen markiert, sodass Sie sich mit der Geschichte vertraut machen können, ohne von der Karte aufzusehen.

Informationen über die Karte wurden eingeholt, unter anderem von Wikipedia und Wikidata. Die Karte ist historisch ungenau, wie viele mit der chinesischen Geschichte vertraute Benutzer berichten. Aber das Projekt enthält die Anfänge einer Wiki-Bearbeitung von Karten, so dass irgendwann die Fehler behoben werden.

Aus dem Einführungsvideo können Sie sich auch über die recht breiten Möglichkeiten informieren, statistische Informationen (wie Bevölkerung, Religionen usw.) über verschiedene Epochen zu visualisieren. Nicht alle diese Visualisierungen sind einfach und visuell, aber die Möglichkeit, dies zu tun, ist großartig.

- Es gibt eine Running Reality-Karte mit einer sehr detaillierten Markierung der Gebiete. Das Projekt will die Geschichte bis hin zur Geschichte der Straßen beschreiben und ermöglicht dafür die Wiki-Bearbeitung der Karte (so wie ich es verstehe, nicht in der Webversion). Sie haben eine ziemlich schlechte Visualisierung historischer Daten, aber ein sehr kompetentes Datenmodell, mit dem Sie alternative Zweige der Geschichte beschreiben können (was nützlich ist, wenn Historiker mehrere Hypothesen darüber haben, „wie alles wirklich passiert ist“). Sie schreiben, dass die Webkarte im Vergleich zur Standalone-Version viel jünger und in ihren Funktionen eingeschränkt ist, und ich habe die Standalone-Version nicht getestet (nicht gestartet). Es ist jedoch genauso kostenlos wie das Internet. Wenn Sie es schaffen, es zu starten, schreiben Sie Ihr Feedback in die Kommentare.

- Ich habe die Geacron-Karte vor langer Zeit gefunden. Es wurde von Historikern aus Quellen und Atlanten gezeichnet, was bedeutet, dass es die Geschichte wahrscheinlich genauer widerspiegelt als andere. Aber die Interaktivität dieser Karte fehlt ernsthaft. Zusätzlich zum Kartenmodus verfügt die Site über eine Zeitleiste für historisch bedeutsame Perioden. Leider, aber von echten Historikern priorisiert. Eines der Probleme mit den vorherigen Karten ist, dass wichtige Ereignisse und vorübergehende Ereignisse gleichberechtigt sind. Geacron scheint dies zu vermeiden, indem es die Daten manuell kuratiert.

- Raumzeitkarte mit Ereignissuche nach Kategorie. Nicht aufrührerisch, aber gut gemacht (und das sogar vor dem Hintergrund einer nahezu null Anzahl solcher Karten...) Und das sind wieder Wikipedia und Wikidata.

- CENTENNIA-eigener Atlas ohne Webversion. Mir scheint, dass Videos wie "1000 Jahre europäische Geschichte in fünf Minuten" normalerweise diese Karte verwenden.

- Timemaps ist ein ziemlich schwacher Klon von Geacron, aber es kann für jemanden bequemer sein.

- upd: Die Geschichte der Urbanisierung - eine animierte Karte, die die Zeit der Entstehung von Städten zeigt.

- upd: Weltbevölkerungsgeschichte - Karte der Bevölkerung im Laufe der Zeit. Es listet auch alle möglichen Dinge wie Lebenserwartung, Treibhausgaswerte usw. auf. Markierte einige wichtige Meilensteine in der Geschichte der Menschheit

- upd2: Wordology - eine Reihe sehr einfacher interaktiver Karten für verschiedene Epochen der Geschichte. Wahrscheinlich Handarbeit. Die Detaillierung ist minimal, die Interaktivität glänzt ebenfalls nicht.

- Historische Zeitleisten bei Histropedia. Ich mag diese Art der Datendarstellung als Zeitachse nicht wirklich, aber a) in Ermangelung besserer Visualisierungstools können Sie sie verwenden, b) diese Zeitleisten sind wirklich gut gemacht und praktisch, c) diese Zeitleisten können bearbeitet werden , sowie eigene erstellen, d ) Sie können Zeitleisten nicht von Hand erstellen, sondern indem Sie Wikidata anfordern, e) Es wurden bereits ziemlich viele Zeitleisten für Sie erstellt, und es ist schön, sie zu studieren.

- Wikijourney - eine Karte mit geogetaggten Wiki-Artikeln über diese Orte. Es soll für Sehenswürdigkeiten verwendet werden, aber Wikipedia hat Artikel über fast jede Straße in Moskau und jede U-Bahn-Station - also sehe ich eine ziemlich banale Liste von "Sehenswürdigkeiten" um mich herum. Auf besagtem Chronoas gibt es übrigens auch Bilder auf der Karte, die irgendwie mit der Ortszeit zu tun haben, der Zeitbezug ist aber eher bedingt: wie alt ist diese Fotografie? ..

- Visualisierungstools für humanitäre Forschungsdaten. Seit einem halben Jahrhundert gibt es eine Wissenschaft der „Digital Humanities“ – Computermethoden der humanitären Forschung. Ich würde sagen, dass diese Wissenschaft kaum schimmert, wenn man bedenkt, wie wenig bisher getan wurde ... aber trotzdem. Daher wurde für Historiker, Philologen, Archäologen und andere Spezialisten eine Reihe von Visualisierungstools entwickelt. Größtenteils handelt es sich dabei um Visualisierungen beliebiger Verbindungen zwischen Objekten. In einem Diagramm, auf einer Karte, in einer Tag-Cloud, in einer Zeitperspektive usw.

Zum Beispiel hat Stanford eine Reihe ähnlicher Tools entwickelt (ich bin mehrmals auf eine Erwähnung ihres Palladio-Tools gestoßen, anscheinend ist dies ihr Haupttool).

Es gibt auch ein NodeGoat-Projekt – sie sind gut geeignet, um verknüpfte Daten zu visualisieren (siehe unten). Hier ist, sagen wir, ihre Kampfkarte basierend auf Daten von Wikidata und dbpedia. Die Karte sieht gut aus, obwohl es nicht sehr bequem ist, durch Links zu verankerten Objekten zu navigieren. Übrigens, wenn Sie zum Beispiel auf einen Punkt mit Ereignissen klicken, die im Zentrum Russlands „passierten“, sehen Sie ein gemeinsames Problem für alle Karten, die durch das Analysieren von Informationen erstellt wurden: falsche Zuordnung eines Ereignisses zu einem Ort und Zeit.

Beschriftete Wissensgraphen oder semantische Netze, das war's. Die leistungsstärkste Technologie zur Erstellung komplexer Suchanfragen. Sie hat sich lange entwickelt, ist aber noch nicht bei den Menschen angekommen. Der Hauptgrund dafür ist die Komplexität der Verwendung und insbesondere die Komplexität des Studiums: Es gibt nur wenige Materialien, und fast alle Materialien sind für Programmierer konzipiert. Ich habe eine kleine gemacht eine Auswahl guter und zugänglicher Lernmaterialien, die es einer einfachen Person ermöglichen wird, dieses Instrument in ein paar Stunden zu beherrschen. Es ist nicht schnell, aber während dieser Zeit wird Ihr "Google-Fu" erheblich zunehmen.

Die Technologie semantischer Netze wird von allen großen Such- und Informationssystemen übernommen. Insbesondere lernen jetzt viele Menschen, natürliche Sprache in formalisierte Abfragen für einen solchen Graphen zu übersetzen. Sicherlich verwenden dies die Ermittlungsbehörden und Geheimdienste (wenn man bedenkt, dass einer der beliebtesten Wissensgraphen laut CIA Factbook erstellt wird). Sie können sich Millionen Möglichkeiten vorstellen, diese Technologie für jede analytische Arbeit einzusetzen: für den Staat, für die Wirtschaft, für die Wissenschaft und sogar für die Haushaltsplanung.

Vielleicht werden Suchmaschinen in ein paar Jahren lernen, einige Ihrer Fragen in natürlicher Sprache zu entschlüsseln und zu beantworten. Aber Sie selbst können jetzt die volle Leistungsfähigkeit dieses Tools nutzen und erhalten viel mehr Flexibilität, als Ihnen jede Suchmaschine geben wird. Hier also die Tutorials:

- Es gibt ein hervorragendes Tutorial „Using SPARQL to access Linked Open Data“ (auf The Programming Historian) darüber, was Linked Data ist und warum es benötigt wird. Ich glaube, dass jeder gebildete Mensch die Grundlagen von SPARQL lernen sollte, genauso wie jeder Mensch googeln können sollte. Es geht buchstäblich darum, komplexe und leistungsstarke Suchanfragen zu erstellen (siehe Beispiele unten). Sie verwenden es vielleicht nicht jeden Tag, aber wenn die nächste Aufgabe des Suchens und Analysierens von Informationen ansteht, die einen Monat manueller Arbeit erfordert, werden Sie wissen, wie Sie es vermeiden können.

Ehrlich gesagt ist der Stoff trotz der guten Präsentation noch ziemlich kompliziert: das RDF-Datenformat, Ontologien und die Abfragesprache SPARQL. Bis ich diesen Artikel gefunden habe, konnte ich nur bewundern, wie cool die Leute es benutzen, aber ich habe nicht verstanden, wie man es überhaupt zum Laufen bringt. Der Programming Historian gibt komplexes Material mit sehr anschaulichen Beispielen und zeigt Ihnen, wie Sie es verwenden.

Ihre Seite ist übrigens schon mit ihrem Namen interessant. Sie bringen Historikern bei, wie man Computerwerkzeuge und Programmierung für die Forschung einsetzt. Denn ein bisschen Programmieren erleichtert jede Arbeit.

- Ein gutes 15-minütiges Einführungs-Video-Tutorial zum Abfragen von Wikidaten und anschließendem Rendern in Histropedia. Eine rein praktische Lektion, nach der Ihnen klar ist, an welchen Knöpfen Sie drücken müssen, um Ihre Anfrage zu verfassen und das Ergebnis in verdaulicher Form zu sehen. Ich empfehle, dieses Video nach dem Tutorial anzusehen und dann mit dem Üben zu beginnen.

- Beispielabfragen, um ein Gefühl für die Leistungsfähigkeit des Tools zu bekommen. Fühlen Sie sich frei, auf "Ausführen" zu klicken. Im Abfragefenster können Sie mit der Maus über Bezeichner fahren – ein Tooltip zeigt Ihnen, was sich hinter den mysteriösen wdt: P31 und wd: Q12136 verbirgt. Also: eine Abfrage, die alle Bürgermeisterinnen von Großstädten zurückgibt bzw. Diese Projekte zielen darauf ab, Quellen für zugehörige maschinenlesbare Daten bereitzustellen, die von der Community kontinuierlich aktualisiert werden. Es gibt auch alle möglichen konservativeren Datenquellen, die von Museen unterstützt werden - über Sammlungen von Kunstgegenständen und Archäologie, Wörterbücher von geografischen Namen und Biographien, biologische Ontologien. Und wahrscheinlich noch viel mehr. Google nach "SPARQL-Endpunkt".

Wie übertragen Menschen soziale Informationen, tauschen sie aus? Dies geschieht vor allem auf der Ebene der persönlichen Kommunikation. Dies geschieht mit Hilfe von Worten, Gesten, Mimik. Diese Art des menschlichen Wissens ist ziemlich informativ, hat aber ihren eigenen erheblichen Nachteil - die persönliche Kommunikation ist zeitlich und räumlich begrenzt.Eine Person hat gelernt, Werke zu schaffen, die ihre Ziele und Absichten zum Ausdruck bringen, und hat es geschafft zu verstehen, dass diese Werke zu Quellen werden können von Informationen, wodurch Menschen Alltagserfahrungen sammeln und an zukünftige Generationen weitergeben. Dazu kodieren sie es in materielle Objekte.

Quellenkunde ist eine Methode der Erkenntnis der realen Welt. Das Objekt sind in diesem Fall Kulturgüter, die von Menschen geschaffen wurden – Werke, Dinge, Aufzeichnungen – Dokumente.

Da Menschen zielgerichtet Werke schaffen, spiegeln diese Werke diese Ziele wider, die Wege, sie zu erreichen, und die Möglichkeiten, die Menschen unter bestimmten Bedingungen zu der einen oder anderen Zeit hatten. Daher können Sie durch das Studium von Werken viel über die Menschen lernen, die sie geschaffen haben, und diese Erkenntnismethode wird von der Menschheit weit verbreitet.

Frage 45

Historische Quellen- der gesamte Komplex von Dokumenten und Objekten der materiellen Kultur, die den historischen Prozess direkt widerspiegelten und einzelne Fakten und vergangene Ereignisse erfassten, auf deren Grundlage die Idee einer bestimmten historischen Ära neu erstellt wird, über die Hypothesen aufgestellt werden Ursachen oder Folgen bestimmter historischer Ereignisse

Es gibt viele historische Quellen, also sind sie klassifiziert. Es gibt keine einheitliche Klassifizierung, da jede Klassifizierung bedingt und sogar umstritten ist. Einer bestimmten Klassifikation können unterschiedliche Grundsätze zugrunde liegen.

Daher gibt es mehrere Arten der Klassifizierung. Zum Beispiel werden historische Quellen unterteilt in absichtlich und unabsichtlich. Unbeabsichtigte Quellen sind das, was ein Mensch geschaffen hat, um sich mit allem Notwendigen zum Leben zu versorgen. Absichtliche Quellen werden mit einem anderen Zweck erstellt - um sich selbst zu erklären, um die Geschichte zu prägen.

Nach einer anderen Klassifizierung werden Quellen unterteilt in Material(von Menschenhand gemacht) und spirituell. Zur gleichen Zeit hat ein prominenter russischer Historiker A.S. Lappo-Danilevsky argumentierte, dass alle Quellen, einschließlich der materiellen, „Produkte der menschlichen Psyche“ 2 seien.

Es gibt andere Einteilungen historischer Quellen: Sie werden nach Entstehungsperioden, Typen (Schriftquellen, Memoiren, Medienmaterialien usw.), in verschiedenen Bereichen der Geschichtswissenschaft (in der Politik-, Wirtschafts-, Kulturgeschichte usw.) . . ).

Betrachten Sie die allgemeinste Klassifizierung historischer Quellen.

1. Schriftliche Quellen:

gedruckte Materialien

Manuskripte - auf Birkenrinde, Pergament, Papier (Chroniken, Chroniken, Briefe, Verträge, Dekrete, Briefe, Tagebücher, Memoiren)

epigraphische Denkmäler - Inschriften auf Stein, Metall usw.

Graffiti - an die Wände von Gebäuden, Geschirr gekritzelte Texte

2. Real(Werkzeuge, Kunsthandwerk, Kleidung, Münzen, Medaillen, Waffen, architektonische Strukturen usw.)

3. Bußgeld(Gemälde, Fresken, Mosaike, Illustrationen)

4.Folklore(Denkmäler der mündlichen Volkskunst: Lieder, Legenden, Sprichwörter, Redewendungen, Anekdoten usw.)

5.Sprachlich(Ortsnamen, Personennamen)

6. Film- und Fotodokumente(Filmdokumente, Fotografien, Tonaufnahmen)

Die Suche nach historischen Quellen ist der wichtigste Bestandteil der wissenschaftlichen Arbeit. Aber Quellen allein reichen nicht aus, um Geschichte angemessen wiederzugeben. Sie brauchen auch die Fähigkeit, mit historischen Quellen zu arbeiten, die Fähigkeit, sie zu analysieren.

Die Zeit ist längst vorbei, in der alle Beweise einer Quelle für bare Münze genommen wurden. Die moderne Geschichtswissenschaft geht von dem Axiom aus, dass das Zeugnis jeder Quelle einer sorgfältigen Überprüfung bedarf. Dies gilt auch für narrative Quellen (also Zeugen- und Augenzeugenberichte) und Dokumente, die einen wichtigen Stellenwert in der Forschung einnehmen.

Frage 46

Die Forschungspraxis ist eine endlose Bewegung hin zu einer vollständigeren und tieferen Kenntnis der historischen Realität. Die Quelle, auch wenn sie Teil einer Tatsache ist, gibt uns keine Vorstellung von der Tatsache als Ganzes. Keine Quelle kann mit der historischen Realität identifiziert werden. Wenn wir also über die Zuverlässigkeit der Quelle sprechen, sprechen wir über den Grad der Einhaltung, die darin enthaltenen Informationen und das angezeigte Phänomen. Das Konzept der „Zuverlässigkeit“ impliziert daher nicht absolute (100 %) Konformität, sondern relative.

Wenn die Phase der Quelleninterpretation die Schaffung eines psychologisch zuverlässigen Bildes des Autors der Quelle beinhaltet, die Verwendung von Kategorien wie gesunder Menschenverstand, Intuition, Sympathie, Empathie zusammen mit den logischen Kategorien des Erkenntnisprozesses, dann wiederum in der Phase der Inhaltsanalyse, logische Urteile und Beweise, Vergleich von Daten, Analyse ihrer Konsistenz untereinander. Dieser Ansatz hilft, schwierige Fragen der Objektivität humanitären Wissens zu lösen.

Der Forscher kann nur den Grad der Übereinstimmung mit dem Tatsachenereignis feststellen, nicht aber seine Identität. Anhand der Quelle rekonstruiert, modelliert der Forscher lediglich den Sachverhalt (Objekt) – verbal oder mit Hilfe anderer Mittel. Und wenn das Objekt selbst systemisch ist, bedeutet dies nicht, dass unser Wissen darüber systematisch ist. Die allgemeine humanitäre Methode der Quellenkunde erlaubt es in diesem Fall, den Grad der Annäherung an das Wissen um die Realität der Vergangenheit zu bestimmen. Dabei helfen auch die Kategorien wie Vollständigkeit und Richtigkeit.

Die Vollständigkeit der Quelle ist eine Reflexion der definierenden Merkmale, der wesentlichen Merkmale des untersuchten Objekts, der Merkmale des Phänomens und des Hauptinhalts der Ereignisse in der Quelle. Mit anderen Worten, wenn wir uns anhand der Quelle eine gewisse Vorstellung von der wahren Tatsache der Vergangenheit machen können, können wir von der Vollständigkeit der Quelle sprechen. Darüber hinaus finden wir in historischen Quellen oft eine Darstellung einer Vielzahl kleiner Faktoren und Details. Sie geben keine Möglichkeit, sich einen Eindruck über das untersuchte Phänomen, Ereignis oder Tatsache zu bilden. Aber ihre Anwesenheit ermöglicht es uns, unser Wissen zu konkretisieren. In diesem Fall können wir von der Genauigkeit der historischen Quellenangaben sprechen, also davon, inwieweit darin einzelne Details vermittelt werden.

Vollständigkeit ist ein qualitatives Merkmal, sie ist nicht direkt von der Informationsmenge abhängig. Zwei Seiten Text, eine kleine Skizze (Skizze) können eine bessere Vorstellung davon vermitteln, was passiert ist, als ein gewichtiger Band eines Manuskripts, ein riesiges Bild usw.

Genauigkeit hingegen ist ein quantitatives Merkmal: der Grad der Reflexion in der Quelle einzelner Details des beschriebenen Sachverhalts. Es kommt im Wesentlichen auf die Menge an Informationen an. Daher gibt es keine sehr enge (wie Mathematiker sagen würden, direkt proportionale) Verbindung zwischen Genauigkeit und Erinnerung. Die Fülle an Informationen, die Aufzählung von Details hingegen kann es schwierig machen, die Quelleninformationen wahrzunehmen und zu verstehen. Gleichzeitig ermöglicht die Anzahl der Details in einem bestimmten Stadium, den Hauptinhalt von Ereignissen (Übergang von Quantität zu Qualität) deutlich zu verdeutlichen. So wie die Veredelung verschiedener Fragmente eines einzelnen Bildes zur Entstehung einer Vorstellung von ihm als Ganzes beiträgt.

Der nächste Punkt ist die Klärung der Herkunft der Informationen: ob es sich um Informationen handelt, die auf persönlicher Beobachtung beruhen, oder ob diese Informationen geliehen sind. Natürlich vertrauen wir intuitiv eher den Informationen, die wir selbst beobachten können („Besser einmal sehen als hundertmal hören“ – ist das nicht der magische Effekt von Wochenschauen). Auch die Autoren der Quellen wussten um diese Tatsache. Daher besteht die erste Bedingung darin, die Beweise für die persönliche Beobachtung zu klären, auch wenn der Autor versucht, dies zu beweisen. Die Kenntnis der Umstände des Auftretens (Ort, Zeit, Umstände) und der psychologischen Eigenschaften des Quellenschöpfers ermöglicht es in diesem Stadium, seine Aussagen erheblich zu korrigieren.

Die Hauptsache bei der Kritik an der Zuverlässigkeit einer Quelle ist die Feststellung interner Widersprüche oder Widersprüche mit Berichten aus anderen Quellen in der analysierten Quelle und die Gründe für diese Widersprüche. Beim Vergleich von Quellen hat der Forscher nicht immer die Möglichkeit, diejenigen als Kriterium heranzuziehen, deren Zuverlässigkeit nicht in Frage gestellt wird. Daher muss häufig auf eine Kreuzvalidierung zurückgegriffen werden. Bei Abweichungen muss entschieden werden, welche der Quellen als zuverlässiger angesehen wird. In diesem Fall ist es notwendig, sich an den Ergebnissen der Quellenkritik zu orientieren.

Frage 47

Beim Extrahieren von Informationen aus einer Quelle muss der Forscher zwei wesentliche Punkte beachten:

· Die Quelle gibt nur die Informationen, die der Historiker darin sucht, sie beantwortet nur die Fragen, die der Historiker ihm stellt. Und die Antworten, die Sie erhalten, hängen ganz von den Fragen ab, die Sie stellen.

· Eine schriftliche Quelle vermittelt Ereignisse durch die Weltanschauung des Autors, der sie erstellt hat. Dieser Umstand ist wichtig, weil dieses oder jenes Verständnis des Bildes der Welt, das im Kopf des Schöpfers der Quelle existiert, auf die eine oder andere Weise die Daten beeinflusst, die er festlegt.

Da historische Quellen verschiedenster Art von Menschen im Prozess bewussten und zielgerichteten Handelns geschaffen werden und ihnen zur Erreichung bestimmter Ziele dienen, enthalten sie wertvolle Informationen über ihre Schöpfer und über die Zeit ihrer Entstehung. Um diese Informationen zu extrahieren, ist es notwendig, die Merkmale und Bedingungen für die Entstehung historischer Quellen zu verstehen. Dabei ist es wichtig, Informationen nicht nur aus der Quelle zu extrahieren, sondern auch kritisch zu bewerten und richtig zu interpretieren.

Deutung werden durchgeführt, um (bis zu einem gewissen Grad, soweit möglich, unter Berücksichtigung der zeitlichen, kulturellen und sonstigen Distanz, die den Autor des Werks und den Forscher trennt) die Bedeutung festzustellen, die der Autor dem Werk gegeben hat . Von der Interpretation bewegt sich der Forscher zu Analyse Sein Inhalt. Es wird für ihn notwendig, die Quelle und ihre Beweise mit den Augen eines modernen Forschers eines Mannes aus einer anderen Zeit zu betrachten. Der Forscher deckt die Fülle der sozialen Informationen der Quelle auf und löst das Problem ihrer Zuverlässigkeit. Er bringt Argumente für seine Version der Richtigkeit der Beweise vor und begründet seine Position.

Laut Mark Blok sagen die Quellen selbst nichts. Der Historiker, der die Quellen studiert, muss in ihnen die Antwort auf eine bestimmte Frage suchen. Je nach Fragestellung kann die Quelle unterschiedliche Angaben machen. Blok führt als Beispiel das Leben der Heiligen des frühen Mittelalters an. Diese Quellen enthalten in der Regel keine zuverlässigen Informationen über die Heiligen selbst, aber sie geben Aufschluss über die Lebensweise und das Denken ihrer Autoren.

Der Kulturhistoriker Vladimir Bibler glaubte, dass zusammen mit einer historischen Quelle, die von Menschenhand aus der Vergangenheit geschaffen wurde, ein „Fragment der vergangenen Realität“ in unsere Zeit gelangt. Nach positiver Quellenidentifikation beginnt der Forscher mit rekonstruktiver Arbeit: Abgleich mit bereits bekannten Quellen, gedankliche Vervollständigung, Lückenfüllung, Korrektur von Verzerrungen und Klärung späterer Ablagerungen und subjektiver Deutungen. Die Hauptsache für den Historiker ist festzustellen, ob das in der Quelle beschriebene oder von ihm berichtete Ereignis eine Tatsache ist und ob diese Tatsache wirklich war oder passiert ist. Dadurch erweitert der Historiker das in unsere Zeit gefallene Fragment vergangener Wirklichkeit und erweitert gleichsam seinen „historischen Bereich“, rekonstruiert die Quelle selbst vollständiger, vertieft ihre Deutung und ihr Verständnis und steigert historisches Wissen:

Indem wir die historische Tatsache entschlüsseln, beziehen wir Fragmente der Realität der Vergangenheit in die moderne Realität ein und enthüllen damit den Historismus der Moderne. Wir selbst entwickeln uns als Kultursubjekte, das heißt als Subjekte, die ein langes historisches Leben hinter sich haben (100, 300, 1000 Jahre), wir agieren als historisch denkwürdige Subjekte.

Trotz der Tatsache, dass der rechte Teil der Inschrift nicht erhalten ist, waren Versuche, den Brief zu entziffern, erfolgreich. Es stellte sich heraus, dass es notwendig war, es vertikal zu lesen, den Buchstaben der unteren Zeile zum Buchstaben der oberen Zeile hinzuzufügen und dann wieder von vorne zu beginnen und so weiter bis zum letzten Buchstaben. Einige der fehlenden Buchstaben wurden in ihrer Bedeutung wiederhergestellt. Die unverständliche Inschrift war ein Scherz eines Schülers aus Nowgorod, der schrieb: "Der Ignorant des Schreibens ist nicht der Gedanke des Kaz, sondern wer ist das Zitat ..." - "Das Unwissende hat geschrieben, das Nichtdenken hat gezeigt, und wer liest das ...". Durch die Arbeit mit einem Stück Birkenrinde entzifferte der Forscher nicht nur die Inschrift, sondern bekam auch eine Vorstellung vom Charakter der Menschen und der damaligen Kultur. Er generierte auch neues Wissen über die alte russische Kultur und über die Psychologie der Menschen der untersuchten Epoche oder erweiterte mit den Worten von Bibler den Bereich eines Fragments der Vergangenheit:

In unserer Zeit gibt es nun (tatsächlich) genau so einen wirklich aussagekräftigen Birkenrindenbuchstaben. Es gibt und gibt es tatsächlich ein Stück Alltag des XII Jahrhunderts. zusammen mit dem charakteristischen unhöflichen Humor, Schabernack, "Schrott" von Beziehungen.

Eine erfolgreiche Arbeit mit historischen Quellen erfordert nicht nur Sorgfalt und Unvoreingenommenheit, sondern auch einen breiten kulturellen Blick.

Frage 48 Kritik an der Quelle

Jede Quelle enthält Informationen, Inhalte. Der Forscher betrachtet zwei Aspekte - die Vollständigkeit der Quelle und ihre Zuverlässigkeit. Die erste wird als Informationskapazität verstanden, d.h. der Forscher schaut sich an, worüber der Autor der Quelle schreibt, was er sagen wollte, was er geschrieben hat, was der Autor wusste, aber nicht geschrieben hat, es gibt explizite Informationen und es gibt versteckte Informationen. Die Vollständigkeit der Quelle wird im Vergleich mit anderen Quellen untersucht, die demselben Ereignis gewidmet sind. Enthält es eindeutige Informationen? Danach untersucht der Forscher die Zuverlässigkeit der Quelle. Es zeigt, wie das Schreiben von Tatsachen realen historischen Ereignissen entspricht. Das ist die Apotheose der Kritik. Es gibt zwei Möglichkeiten, die Wahrheit herauszufinden:

1. Vergleichende Rezeption: Die uns interessierende Quelle wird mit anderen Quellen verglichen. Wir müssen bedenken, dass wir bei Vergleichen die Quellen einer absoluten Übereinstimmung in der Beschreibung nicht verlangen sollten. Eine gewisse Ähnlichkeit ist zu erwarten. Verschiedene Arten von Quellen beschreiben dieselben Ereignisse auf unterschiedliche Weise.

2. Logische Technik: unterteilt in zwei Unterarten: Studie mit T. sp. formale Logik, Studium bei T. sp. echte Logik.

Kritik von außen- umfasst eine Analyse der äußeren Merkmale des vorliegenden Materials, um dessen wahrscheinliche Herkunft und Authentizität festzustellen Die schriftliche Quelle ist auf wahrscheinliche Urheberschaft, Entstehungszeit und -ort sowie Papier, Handschrift, Sprache zu prüfen Korrekturen und Einfügungen ...

Dann beginnt der nächste Schritt: Interne Kritik. Hier geht es nicht mehr um die Form, sondern um den Inhalt. Für Autorenquellen sind daher eher die Verfahren der Binnenkritik relevant, außerdem werden sowohl der Inhalt des Textes als auch die Persönlichkeit des Autors (soweit ermittelbar war) analysiert. Wer war der Autor? Welche Gruppe könnte er repräsentieren? Was war der Zweck dieses Textes? Für welches Publikum war es gedacht? Wie verhalten sich die Informationen in diesem Text im Vergleich zu anderen Quellen? Die Anzahl solcher Fragen kann Dutzende betragen ... Und nur ein Teil der Informationen, die allen Phasen der Kritik und des Vergleichs mit Parallelquellen standgehalten haben, kann als relativ zuverlässig angesehen werden, und nur dann, wenn sich herausstellt, dass der Autor keine offensichtlichen hatte Grund, die Wahrheit zu verdrehen.

Frage 49 Kritik und Quellenangabe

Der Forscher muss die Bedeutung bestimmen und verstehen, die der Schöpfer der Quelle in diese Arbeit gelegt hat. Aber zuerst müssen Sie den Namen des Autors der Quelle festlegen. Wenn Sie den Namen des Autors oder Erstellers der Quelle kennen, können Sie den Ort, die Zeit und die Umstände der Quelle sowie das soziale Umfeld, in dem sie entstanden ist, genauer bestimmen. Das Ausmaß der Persönlichkeit des Werkschöpfers, der Fertigstellungsgrad des Werks, der Zweck seiner Entstehung – all diese Parameter bestimmen die Gesamtheit der Informationen, die daraus gewonnen werden können. „Den Autor eines Werkes zu sehen und zu verstehen bedeutet, ein anderes, fremdes Bewusstsein und seine Welt, also ein anderes Thema, zu sehen und zu verstehen“, schrieb M.M. Bakhtin: Sowohl bei der Datierung als auch bei der Lokalisierung und Zuschreibung werden also zwei miteinander verbundene Aufgaben gelöst:

Direkte Verweise auf den Autor. Eine wichtige Grundlage für die Feststellung der Identität einer Person stellt die direkte Angabe des eigenen Namens oder des Anthropotoponyms einer Person dar. Bei einem Personennamen wurde in der Antike unserer Geschichte zwischen einem kanonischen (Paten-, Mönchs- oder Schema) und einem nicht-kanonischen Namen unterschieden. Als Ergebnis, wie E.M. Zagorulsky, - manchmal hat man den Eindruck, dass verschiedene Prinzen handeln, obwohl es sich in Wirklichkeit um ein und dieselbe Person handelt.

Die Identifizierung der Merkmale des Autors wurde häufig durchgeführt, indem die äußeren Details des einer bestimmten Person innewohnenden Stils des Autors festgelegt wurden, insbesondere Lieblingswörter, -begriffe sowie Phraseologiewendungen und -ausdrücke (Autorenstil).

Bei der Etablierung der Autorschaft verbreitete sich die Stiltheorie, zu deren Entwicklung V.V. Winogradow. Nach dem System von V. V. Vinogradov sind die bestimmenden Indikatoren für die Gemeinsamkeit des Stils lexikalische und phraseologische Merkmale und dann grammatikalische. Gleichzeitig muss die Gefahr berücksichtigt werden, die soziale Gruppe oder das Genre mit dem Individuum zu verwechseln.

Die Verwendung dieses Ansatzes wird oft durch die Tatsache erschwert, dass der Autor ziemlich oft imitiert, ein normaler Compiler zu sein. Die Krise traditioneller Attributionsmethoden führte dazu, dass in den 1960er-1970er Jahren. Die Zahl der Forscher, die neue mathematische und statistische Methoden zur Feststellung der Autorschaft entwickelten, begann allmählich zu wachsen.Der Einsatz von Computertechnologie trug zum quantitativen Wachstum solcher Studien und zur Erweiterung ihrer Geographie bei. Hervorzuheben sind die Arbeiten zur Formalisierung von Texten, die von einem Forscherteam der Moskauer Staatlichen Universität (L. V. Milov; L. I. Borodkin usw.) durchgeführt wurden. In einem formalisierten Text wurden gepaarte Vorkommen (d. h. Nachbarschaften) bestimmter Klassen (Formen) offenbart.

Kritik von außen- beinhaltet eine Analyse der äußeren Merkmale des verfügbaren Materials, um seine wahrscheinliche Herkunft und Authentizität festzustellen. Urheberschaft, Entstehungszeit und -ort, sowie Papier, Handschrift, Sprache, Prüfung auf Korrekturen und Beilagen ...

Interne Kritik. Hier geht es nicht mehr um die Form, sondern um den Inhalt. Daher sind interne Kritikverfahren relevanter für Autorenquellen. Darüber hinaus werden sowohl der Inhalt des Textes als auch die Identität des Autors (sofern festgestellt werden konnte) analysiert. Wer war der Autor? Welche Gruppe könnte er repräsentieren? Was war der Zweck dieses Textes? Für welches Publikum war es gedacht? Wie verhalten sich die Informationen in diesem Text im Vergleich zu anderen Quellen?

Das Wort „Informationen“ stammt aus dem Lateinischen Information, was übersetzt Klarstellung, Präsentation bedeutet. Im erklärenden Wörterbuch von V.I. Dahl kennt das Wort „Information“ nicht. Der Begriff „Information“ wurde in der russischen Sprache ab Mitte des 20. Jahrhunderts verwendet.

Der Informationsbegriff verdankt seine Verbreitung im Wesentlichen zwei wissenschaftlichen Bereichen: Kommunikationstheorie und Kybernetik. Das Ergebnis der Entwicklung der Kommunikationstheorie war Informationstheorie gegründet von Claude Shannon. K. Shannon hat jedoch keine Definition von Information gegeben und gleichzeitig definiert Menge an Informationen. Die Informationstheorie widmet sich der Lösung des Problems der Informationsmessung.

In der Wissenschaft Kybernetik von Norbert Wiener gegründet, steht der Informationsbegriff im Mittelpunkt (vgl. "Kybernetik"). Es ist allgemein anerkannt, dass es N. Wiener war, der den Informationsbegriff in den wissenschaftlichen Gebrauch eingeführt hat. Dennoch definiert N. Wiener in seinem ersten Buch über Kybernetik Information nicht. „ Information ist Information, nicht Materie oder Energie“, schrieb Wiener. Damit steht der Informationsbegriff einerseits den Begriffen Materie und Energie gegenüber, andererseits wird er diesen Begriffen im Grad ihrer Allgemeingültigkeit und Fundamentalität gleichgestellt. Damit ist zumindest klar, dass Information etwas ist, das weder Materie noch Energie zugeordnet werden kann.

Informationen in der Philosophie

Die Wissenschaft der Philosophie befasst sich mit dem Verständnis von Information als grundlegendem Konzept. Nach einem der philosophischen Konzepte Information ist eine Eigenschaft von allem, alle materiellen Gegenstände der Welt. Dieses Informationskonzept heißt attributiv (Information ist ein Attribut aller materiellen Objekte). Informationen in der Welt entstanden zusammen mit dem Universum. In diesem Sinne Information ist ein Maß für Ordnung, Strukturiertheit jedes materiellen Systems. Die Entwicklungsprozesse der Welt vom anfänglichen Chaos nach dem "Urknall" über die Bildung anorganischer Systeme bis hin zu organischen (lebenden) Systemen sind mit dem Wachstum des Informationsgehalts verbunden. Dieser Inhalt ist objektiv, unabhängig vom menschlichen Bewusstsein. Ein Stück Kohle enthält Informationen über Ereignisse, die in der Antike stattfanden. Allerdings kann nur ein neugieriger Geist diese Informationen extrahieren.

Ein anderer philosophischer Begriff der Information heißt funktionell. Nach dem funktionalen Ansatz Informationen erschienen mit der Entstehung des Lebens, da sie mit dem Funktionieren komplexer selbstorganisierender Systeme verbunden sind, zu denen lebende Organismen und die menschliche Gesellschaft gehören. Man kann auch sagen: Information ist ein Attribut, das nur der belebten Natur innewohnt. Dies ist eines der wesentlichen Merkmale, die das Lebende vom Unbelebten in der Natur trennen.

Der dritte philosophische Informationsbegriff ist anthropozentrisch, wonach Informationen existieren nur im menschlichen Bewusstsein, in der menschlichen Wahrnehmung. Die Informationsaktivität ist nur dem Menschen eigen und findet in sozialen Systemen statt. Durch die Schaffung von Informationstechnologie schafft eine Person Werkzeuge für ihre Informationstätigkeit.

Wir können sagen, dass die Verwendung des Begriffs „Information“ im Alltag in einem anthropozentrischen Kontext erfolgt. Es ist für jeden von uns ganz natürlich, Informationen als Nachrichten wahrzunehmen, die zwischen Menschen ausgetauscht werden. Zum Beispiel Massenmedien – Massenmedien sind darauf ausgelegt, Nachrichten, Neuigkeiten in der Bevölkerung zu verbreiten.

Informationen in der Biologie

Im 20. Jahrhundert durchdringt der Informationsbegriff die Wissenschaft überall. Informationsprozesse in der belebten Natur werden von der Biologie untersucht. Die Neurophysiologie (Teilbereich Biologie) untersucht die Mechanismen der Nerventätigkeit von Tieren und Menschen. Diese Wissenschaft baut ein Modell der im Körper ablaufenden Informationsprozesse auf. Die von außen kommenden Informationen werden in Signale elektrochemischer Natur umgewandelt, die von den Sinnesorganen entlang der Nervenfasern zu den Neuronen (Nervenzellen) des Gehirns weitergeleitet werden. Das Gehirn überträgt Steuerinformationen in Form gleichartiger Signale an das Muskelgewebe und steuert so die Bewegungsorgane. Der beschriebene Mechanismus stimmt gut mit dem kybernetischen Modell von N. Wiener überein (vgl. "Kybernetik").

In einer anderen biologischen Wissenschaft - der Genetik - wird das Konzept der Erbinformation verwendet, die in die Struktur von DNA-Molekülen eingebettet ist, die in den Kernen von Zellen lebender Organismen (Pflanzen, Tiere) vorhanden sind. Die Genetik hat bewiesen, dass diese Struktur eine Art Code ist, der das Funktionieren des gesamten Organismus bestimmt: sein Wachstum, seine Entwicklung, seine Pathologien usw. Durch DNA-Moleküle werden Erbinformationen von Generation zu Generation weitergegeben.

Beim Studium der Informatik an der Grundschule (Grundkurs) sollte man sich nicht mit der Komplexität des Problems der Informationsermittlung beschäftigen. Der Begriff der Information wird in einem sinnvollen Zusammenhang gegeben:

Information- Dies ist die Bedeutung, der Inhalt von Nachrichten, die eine Person von der Außenwelt durch ihre Sinne erhält.

Das Konzept der Information wird durch die Kette offenbart:

Botschaft – Bedeutung – Information – Wissen

Ein Mensch nimmt Botschaften mit Hilfe seiner Sinne (meistens durch Sehen und Hören) wahr. Wenn eine Person versteht Bedeutung einer Botschaft eingeschlossen, dann können wir sagen, dass diese Botschaft eine Person trägt Information. Beispielsweise enthält eine Nachricht in einer fremden Sprache keine Informationen für eine bestimmte Person, aber eine Nachricht in einer Muttersprache ist verständlich und daher informativ. Wahrgenommene und im Gedächtnis gespeicherte Informationen werden wieder aufgefüllt Wissen Person. Unser Wissen- Dies ist eine systematisierte (verwandte) Information in unserem Gedächtnis.

Bei der Offenlegung des Informationskonzepts aus der Sicht eines sinnvollen Ansatzes sollte man von den intuitiven Vorstellungen über Informationen ausgehen, die Kinder haben. Es ist ratsam, ein Gespräch in Form eines Dialogs zu führen und den Schülern Fragen zu stellen, die sie beantworten können. Fragen können beispielsweise in der folgenden Reihenfolge gestellt werden.

- Sagen Sie uns, woher Sie Ihre Informationen beziehen?

Sie werden wahrscheinlich zurück hören:

Aus Büchern, Radio- und Fernsehsendungen .

- Am Morgen hörte ich die Wettervorhersage im Radio .

Der Lehrer greift diese Antwort auf und führt die Schüler zu der endgültigen Schlussfolgerung:

- Also wusstest du zuerst nicht, wie das Wetter sein würde, aber nachdem du Radio gehört hattest, begannst du es zu wissen. Nachdem Sie Informationen erhalten haben, haben Sie also neues Wissen erhalten!

So kommt der Lehrer zusammen mit den Schülern zu der Definition: Informationfür eine Person sind dies Informationen, die das Wissen einer Person ergänzen, das sie aus verschiedenen Quellen erhält. Darüber hinaus sollte diese Definition an zahlreichen Beispielen, die Kindern bekannt sind, festgelegt werden.

Nachdem Sie eine Verbindung zwischen Informationen und dem Wissen der Menschen hergestellt haben, kommen Sie unweigerlich zu dem Schluss, dass Informationen der Inhalt unseres Gedächtnisses sind, da das menschliche Gedächtnis das Mittel zur Speicherung von Wissen ist. Es ist vernünftig, solche Informationen interne, betriebliche Informationen zu nennen, die eine Person besitzt. Menschen speichern Informationen jedoch nicht nur in ihrem eigenen Gedächtnis, sondern auch in Aufzeichnungen auf Papier, auf Magnetmedien usw. Solche Informationen können als extern (in Bezug auf eine Person) bezeichnet werden. Damit eine Person es verwenden kann (z. B. um ein Gericht nach einem Rezept zuzubereiten), muss er es zuerst lesen, d. H. wandeln Sie es in ein internes Formular um und führen Sie dann einige Aktionen aus.

Die Frage der Klassifikation von Wissen (und damit Information) ist sehr komplex. In der Wissenschaft gibt es dazu unterschiedliche Herangehensweisen. Mit diesem Thema beschäftigen sich insbesondere Spezialisten aus dem Bereich der künstlichen Intelligenz. Im Rahmen des Grundkurses genügt es, sich auf die Einteilung des Wissens zu beschränken deklarativ und prozedural. Die Beschreibung des deklarativen Wissens kann mit den Worten beginnen: „Ich weiß, dass …“. Beschreibung von prozeduralem Wissen - mit den Worten: "Ich weiß wie ...". Es ist einfach, Beispiele für beide Arten von Wissen zu geben und die Kinder einzuladen, ihre eigenen Beispiele zu finden.

Der Lehrer sollte sich der propädeutischen Bedeutung der Erörterung dieser Fragen für das spätere Kennenlernen des Geräts und der Bedienung des Computers durch die Schüler bewusst sein. Ein Computer hat wie ein Mensch ein internes – operatives – Gedächtnis und ein externes – Langzeitgedächtnis. Die Aufteilung des Wissens in deklarative und prozedurale Informationen kann zukünftig mit der Aufteilung von Computerinformationen in Daten – deklarative Informationen und Programme – prozedurale Informationen verknüpft werden. Die Verwendung der didaktischen Analogie zwischen der Informationsfunktion einer Person und eines Computers ermöglicht es den Schülern, die Essenz des Designs und der Funktionsweise eines Computers besser zu verstehen.

Basierend auf der Position „menschliches Wissen ist gespeicherte Information“ informiert der Lehrer die Schüler darüber, dass Gerüche, Geschmäcker und taktile (taktile) Empfindungen auch Informationen zu einer Person tragen. Der Grund dafür ist sehr einfach: Da wir uns an vertraute Gerüche und Geschmäcker erinnern, vertraute Objekte durch Berührung erkennen, werden diese Empfindungen in unserem Gedächtnis gespeichert und sind daher Informationen. Daher die Schlussfolgerung: Mit Hilfe aller Sinne erhält ein Mensch Informationen von der Außenwelt.

Sowohl aus inhaltlicher als auch aus methodischer Sicht ist es sehr wichtig, zwischen der Bedeutung der Begriffe „ Information" und " Daten”. Zur Darstellung von Informationen in beliebigen Zeichensystemen(einschließlich der in Computern verwendeten) Begriff verwendet werden soll “Daten". ABER Information- Das die in den Daten enthaltene Bedeutung, die von einer Person in sie eingebettet und nur für eine Person verständlich ist.